SLAM(Simultaneous Localization and Mapping)は、ロボットが未知の環境を探索しながら地図を作成し、同時に自己位置を推定する技術です。自動運転車、AGV、ドローン、掃除ロボットなど、あらゆる自律移動システムの基盤技術として不可欠です。本記事では、SLAMの基本原理から実装方法、最新動向まで徹底解説します。

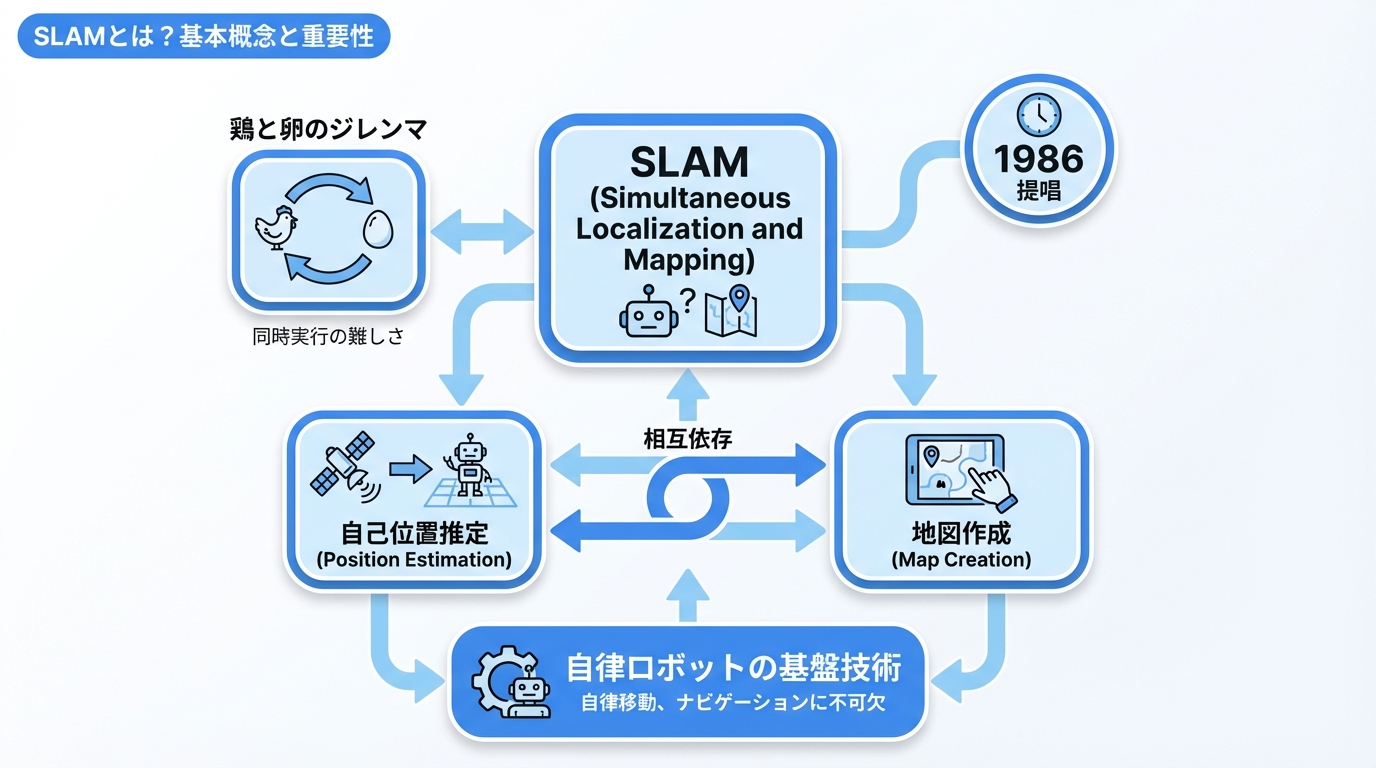

SLAMとは?基本概念と重要性

SLAM(スラム)は「Simultaneous Localization and Mapping」の略で、「自己位置推定」と「地図作成」を同時に行う技術です。1986年に概念が提唱され、現在では自律移動の核心技術となっています。

SLAMが解決する「鶏と卵」問題

自律移動ロボットには以下のジレンマがあります:

- 正確な地図を作るには、自分の位置を知る必要がある

- 正確な位置を知るには、地図が必要

SLAMは、この両方を確率的に同時解決する技術です。

SLAMの基本構成要素

| 要素 | 役割 | 具体例 |

|---|---|---|

| センサー | 環境情報の取得 | LiDAR、カメラ、IMU |

| フロントエンド | 特徴抽出・マッチング | 特徴点検出、スキャンマッチング |

| バックエンド | 最適化・推定 | グラフ最適化、フィルタリング |

| ループクロージング | 累積誤差修正 | 場所の再認識 |

| 地図表現 | 環境の記録 | 点群、グリッド、特徴点 |

AGV・AMRはSLAM技術を活用した代表的な自律移動ロボットです。

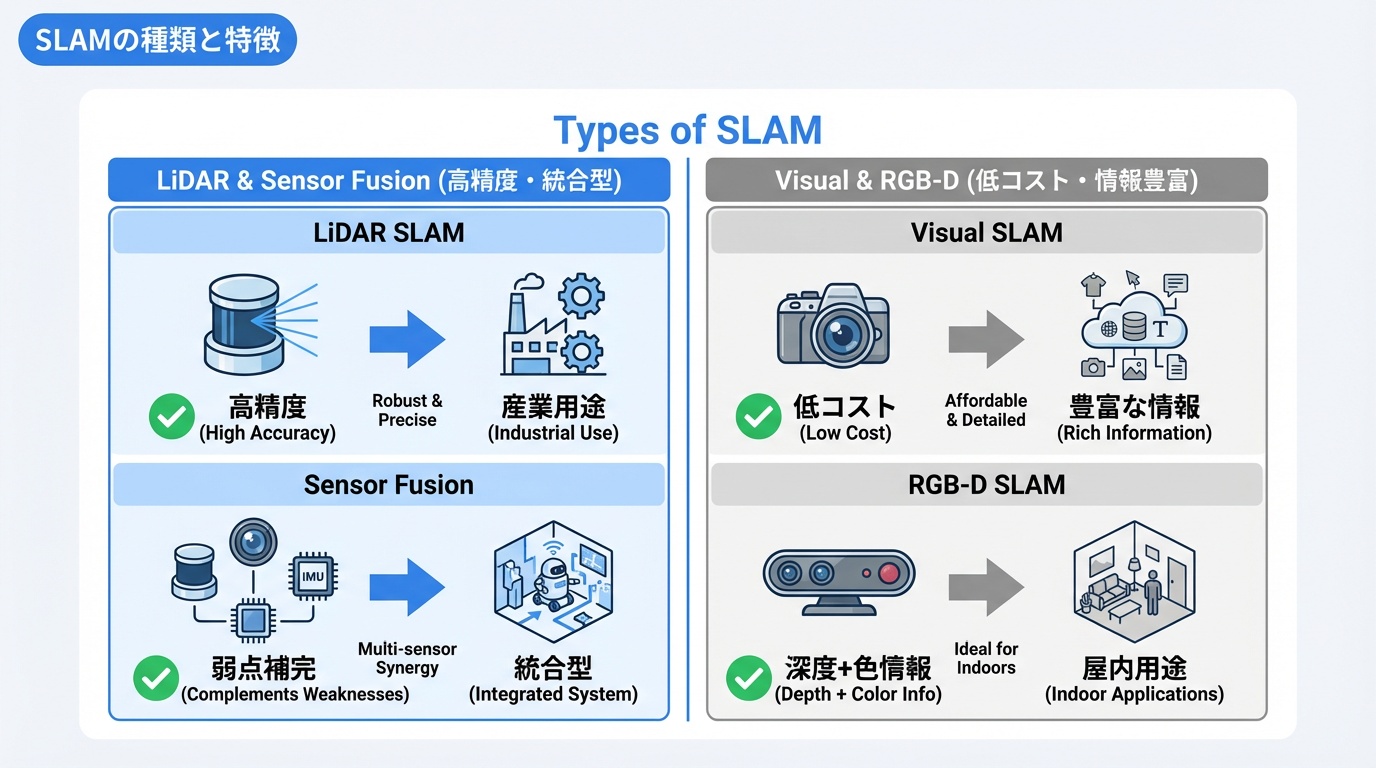

SLAMの種類と特徴

使用するセンサーや手法によって、SLAMは複数の種類に分類されます。

1. LiDAR SLAM

レーザーセンサーで環境をスキャンする方式です。最も精度が高く、産業用途で広く使われています。

| 項目 | 内容 |

|---|---|

| 精度 | 非常に高い(cm級) |

| 環境 | 屋内外両対応 |

| 照明条件 | 影響なし(暗所可) |

| コスト | 高い(数十万〜数百万円) |

| 代表手法 | Cartographer、LOAM、LIO-SAM |

2. Visual SLAM(vSLAM)

カメラ画像を使用する方式です。低コストで豊富な情報が得られます。

| 項目 | 内容 |

|---|---|

| 精度 | 中〜高(環境依存) |

| 環境 | 特徴が多い環境向け |

| 照明条件 | 影響大(暗所苦手) |

| コスト | 低い(カメラのみ) |

| 代表手法 | ORB-SLAM3、RTAB-Map、VINS-Fusion |

3. RGB-D SLAM

深度カメラ(Kinect、RealSense等)を使用する方式です。

- 色情報と深度情報を組み合わせ

- 屋内向け(有効距離に制限)

- 代表手法:RTAB-Map、ElasticFusion

4. センサーフュージョンSLAM

複数センサーを統合する最新のアプローチです。

- LiDAR + カメラ + IMU を統合

- 各センサーの弱点を補完

- 自動運転車で主流

- 代表手法:LVI-SAM、FAST-LIO2

SLAMの主要アルゴリズム解説

代表的なSLAMアルゴリズムの仕組みを解説します。

フィルタベースSLAM

確率的フィルタを用いて逐次的に推定を更新します。

- EKF-SLAM:拡張カルマンフィルタを使用、計算量大

- Particle Filter SLAM:パーティクルで分布を表現

- FastSLAM:効率的なパーティクル更新

グラフベースSLAM

ポーズと観測をグラフ構造で表現し、最適化問題として解きます。現在の主流です。

- ノード:ロボットのポーズ(位置・姿勢)

- エッジ:ポーズ間の制約(オドメトリ、観測)

- 最適化:グラフ全体の整合性を最大化

代表的なオープンソースSLAM

| 名称 | センサー | 特徴 | 用途 |

|---|---|---|---|

| Cartographer | 2D/3D LiDAR | Google開発、高精度 | 屋内AGV |

| ORB-SLAM3 | カメラ/RGB-D | 特徴点ベース、堅牢 | 研究、AR |

| RTAB-Map | RGB-D/LiDAR | 多センサー対応 | 汎用 |

| LIO-SAM | LiDAR+IMU | リアルタイム、高精度 | 自動運転 |

| VINS-Fusion | カメラ+IMU | VIO高精度 | ドローン |

SLAMの応用分野

SLAMは様々な自律移動システムで活用されています。

1. 自動運転車

高精度3D地図の作成と自己位置推定に使用されています。

- LiDAR SLAMによる高精度マッピング

- HDマップとのローカライゼーション

- GPS非依存の自己位置推定

自動運転技術の基盤となっています。

2. 物流・倉庫ロボット

倉庫内の自律走行に不可欠です。

- 施設全体の地図自動生成

- 動的障害物への対応

- フリート全体での地図共有

倉庫ロボットで広く採用されています。

3. 家庭用ロボット

掃除ロボットの主要技術として普及しています。

- 部屋のレイアウト学習

- 効率的な掃除経路計画

- 充電ステーションへの自動帰還

4. ドローン

GPS不可環境での自律飛行に活用されています。

- 屋内・トンネル内の飛行

- 点検・調査ミッション

- Visual-Inertial Odometry(VIO)

5. AR/VR

拡張現実の位置合わせ技術として使用されています。

- Apple ARKit / Google ARCore

- Meta Quest の Inside-Out トラッキング

- Microsoft HoloLens の空間認識

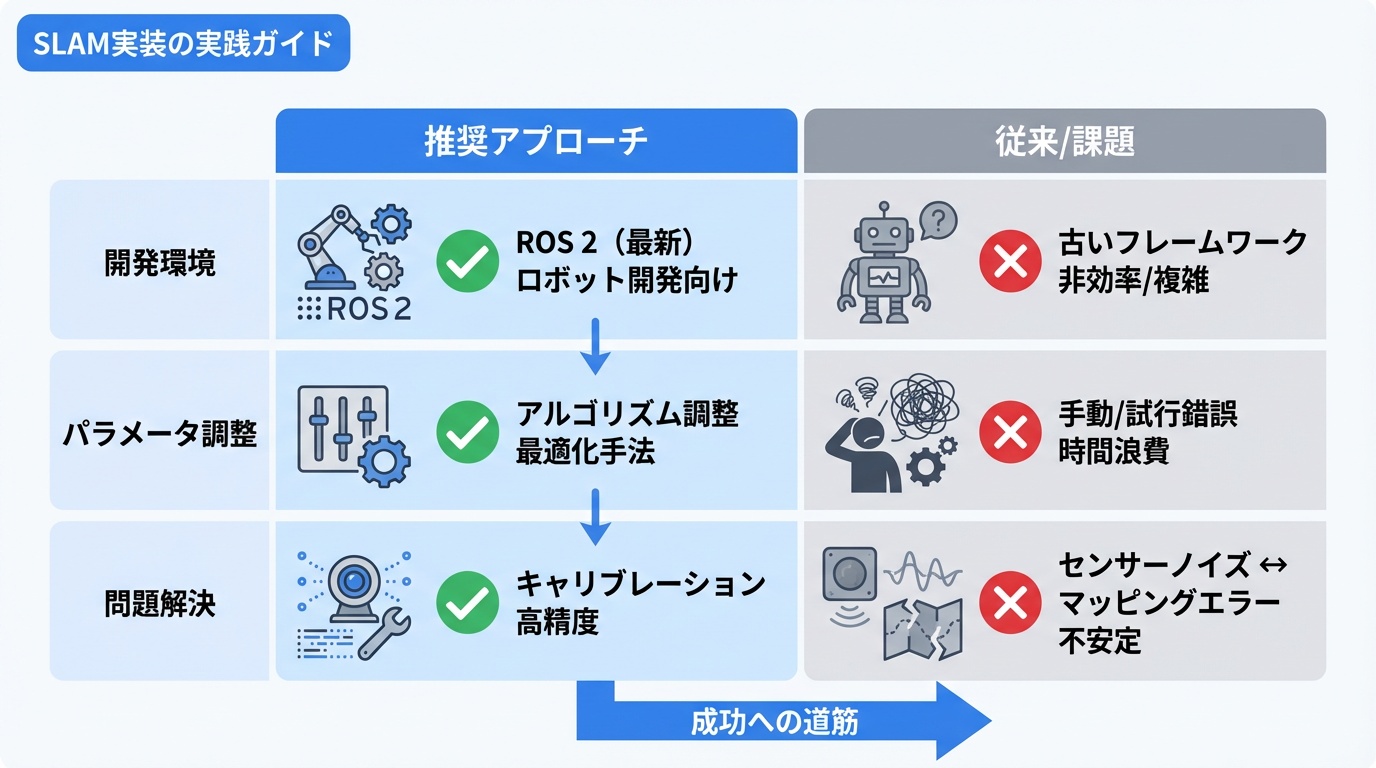

SLAM実装の実践ガイド

SLAMを実際に動かすための実践的なガイドです。

開発環境の構築(ROS 2)

# ROS 2 Humble インストール(Ubuntu 22.04)

sudo apt install ros-humble-desktop

# SLAM関連パッケージ

sudo apt install ros-humble-slam-toolbox

sudo apt install ros-humble-nav2-bringup

sudo apt install ros-humble-cartographer-ros主要パラメータ調整

| パラメータ | 影響 | 調整指針 |

|---|---|---|

| 解像度 | 地図の細かさ | 5cm(屋内)〜20cm(屋外) |

| スキャン間隔 | 処理負荷・精度 | 10Hz程度が一般的 |

| ループ閾値 | 誤検出・見逃し | 環境に応じて調整 |

| 最大距離 | 有効範囲 | センサー特性に合わせる |

典型的な問題と対策

| 問題 | 原因 | 対策 |

|---|---|---|

| ドリフト(累積誤差) | 観測ノイズの蓄積 | ループクロージング強化 |

| 特徴不足 | 単調な環境 | マルチセンサー統合 |

| 動的障害物 | 人や車両の移動 | 動体除去フィルタ |

| 計算負荷 | 大規模環境 | サブマップ分割 |

ROS入門でロボット開発の基礎を学べます。

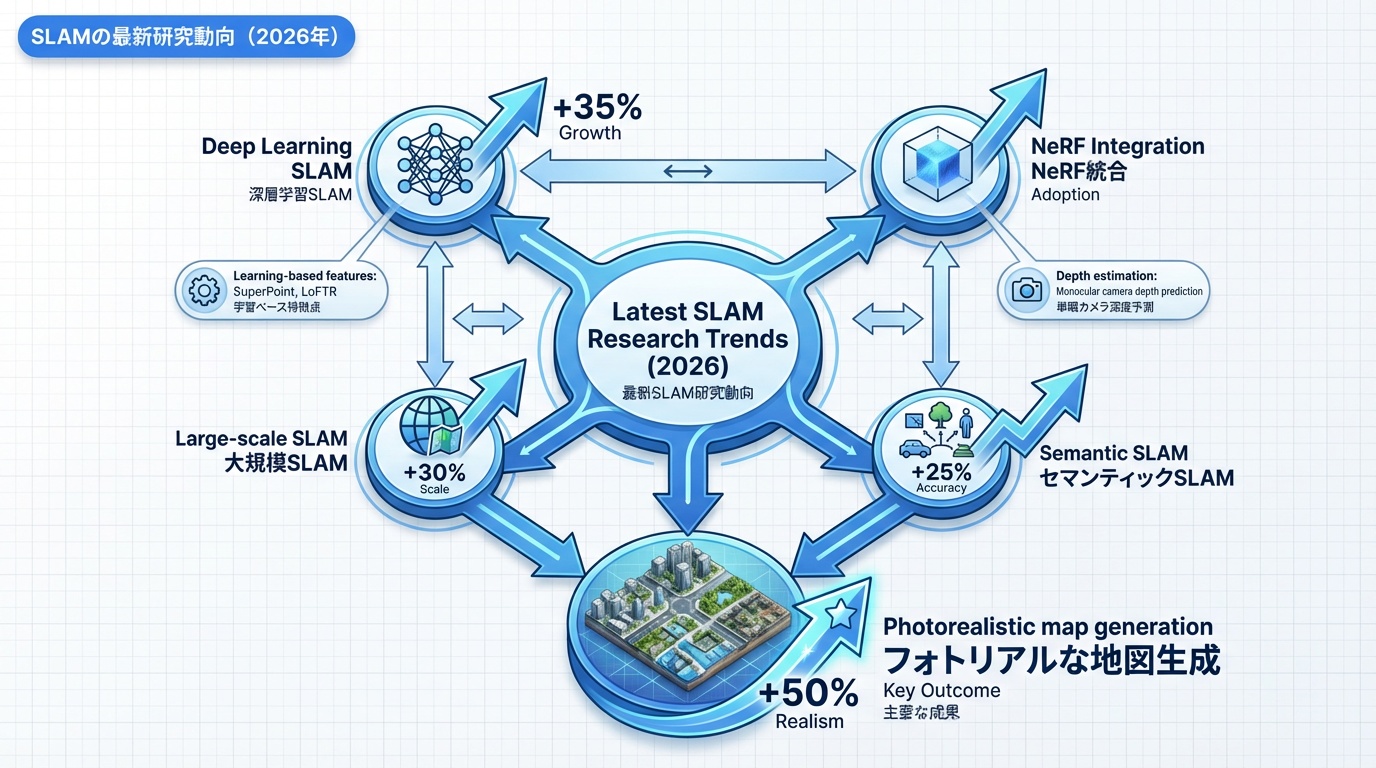

SLAMの最新研究動向(2026年)

SLAM技術は急速に進化しています。最新の研究トレンドを紹介します。

1. ディープラーニングSLAM

ニューラルネットワークを活用した新しいアプローチです。

- 学習ベース特徴:SuperPoint、LoFTR

- 深度推定:単眼カメラから深度を推定

- End-to-End SLAM:全処理をNNで実現

2. Neural Radiance Fields(NeRF)との融合

NeRFによる高品質な3D表現とSLAMの統合が研究されています。

- フォトリアルな地図生成

- 任意視点でのレンダリング

- NICE-SLAM、iMAP等の手法

3. 大規模環境SLAM

都市規模の環境に対応する技術が発展しています。

- 階層的地図表現

- 分散SLAM(複数ロボット協調)

- クラウドSLAM

4. セマンティックSLAM

物体認識と統合し、意味理解を含む地図を作成します。

- 「机」「椅子」などのラベル付き地図

- 物体レベルのSLAM

- タスク指向のナビゲーション

Embodied AIとの統合も進んでいます。

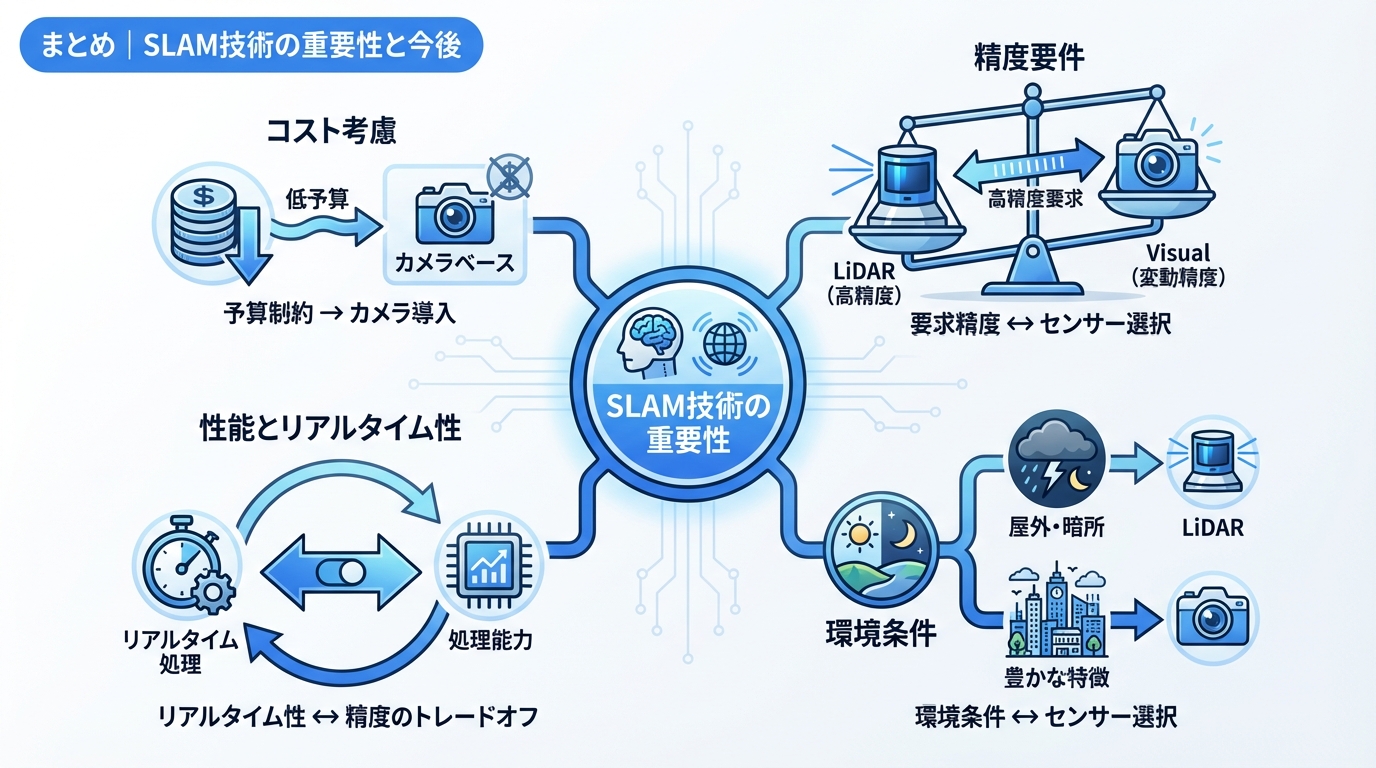

まとめ|SLAM技術の重要性と今後

SLAMは自律移動ロボットの「目」と「脳」として不可欠な技術です。

SLAM選定のポイント

- 精度要件:cm級が必要ならLiDAR、それ以外はVisual

- 環境条件:屋外・暗所ならLiDAR、特徴豊富ならカメラ

- コスト:低予算ならカメラベース

- リアルタイム性:処理能力と精度のトレードオフ

今後の展望

- ディープラーニングとの融合による高性能化

- センサーの低価格化による普及拡大

- 大規模環境・長期運用への対応

- セマンティック理解との統合

関連記事としてフィジカルAIの動向もご覧ください。

https://ainow.jp/agv-amr/

https://ainow.jp/autonomous-driving/

https://ainow.jp/warehouse-robot/

https://ainow.jp/robot-sensor-guide/