AINOW(エーアイナウ)編集部です。製造業の自動化やロボティクスの進化に伴い、ロボットビジョン技術への注目が高まっています。本記事では、ロボットビジョンの基礎概念から画像認識・物体検出技術、3Dビジョン、産業応用まで、初心者にもわかりやすく体系的に解説します。工場の自動化やロボット導入を検討されている方は、ぜひ参考にしてください。

この記事のサマリー

- ロボットビジョンの基礎から応用まで、画像認識・物体検出技術を体系的に解説

- YOLO、SSD、Faster R-CNNなど主要アルゴリズムの特徴と使い分けを紹介

- 2026年最新の生成AI×ビジョン融合、エッジAIビジョンの動向を網羅

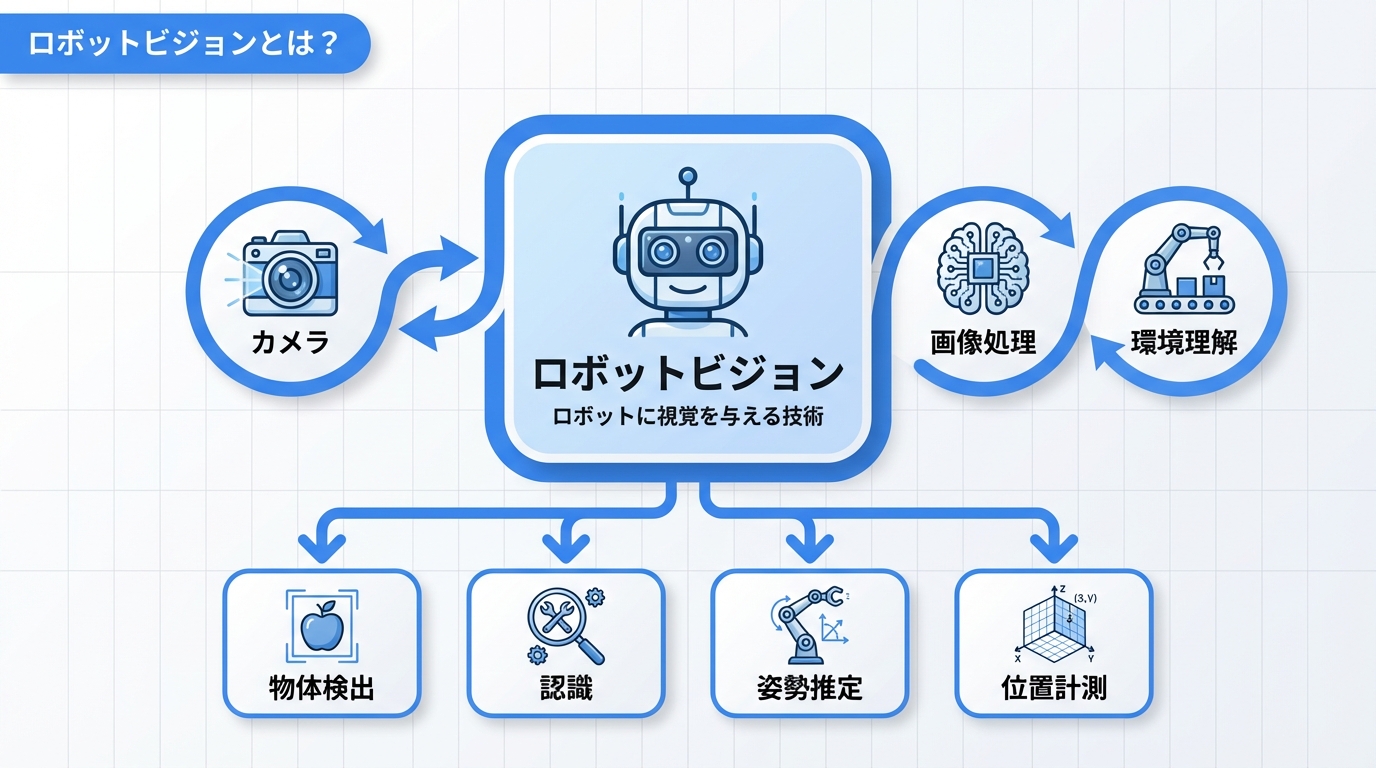

ロボットビジョンとは?

ロボットビジョンは、産業用ロボットや自律移動ロボットに「目」を与える技術です。カメラやセンサーで取得した画像・映像データを処理・解析し、ロボットが周囲の環境を認識して適切な動作を行うための基盤技術として、製造業を中心に幅広い分野で活用されています。

ロボットビジョンの定義

ロボットビジョンとは、ロボットシステムにおける視覚機能全般を指す技術領域です。具体的には、カメラなどの撮像装置で取得した画像データを解析し、対象物の位置・形状・姿勢を認識してロボットの動作制御にフィードバックする一連のプロセスを含みます。

主な機能として以下が挙げられます。

- 物体検出:画像内の対象物を特定し、位置座標を取得

- 物体認識:対象物の種類・クラスを分類

- 姿勢推定:対象物の3D空間における向き・傾きを算出

- 位置計測:対象物とロボットの相対的な距離・位置関係を計算

|

マシンビジョンとの違い

ロボットビジョンと混同されやすい用語に「マシンビジョン」があります。両者の違いを明確にしておきましょう。

| 項目 | ロボットビジョン | マシンビジョン |

|---|---|---|

| 主な目的 | ロボット動作の制御・誘導 | 検査・計測・識別 |

| 対象システム | 産業用ロボット、自律移動ロボット | 検査装置、計測装置 |

| 処理の特徴 | リアルタイム性、3D処理重視 | 高精度、高速処理重視 |

| 出力 | 座標値、姿勢データ | 良否判定、寸法値 |

| 典型的な用途 | ピッキング、組立、溶接 | 外観検査、寸法測定 |

マシンビジョンは検査・計測に特化した技術であり、ロボットビジョンはマシンビジョンの技術をロボット制御に応用したものと捉えることができます。近年では両者の境界は曖昧になりつつあり、統合的なビジョンシステムが主流になっています。

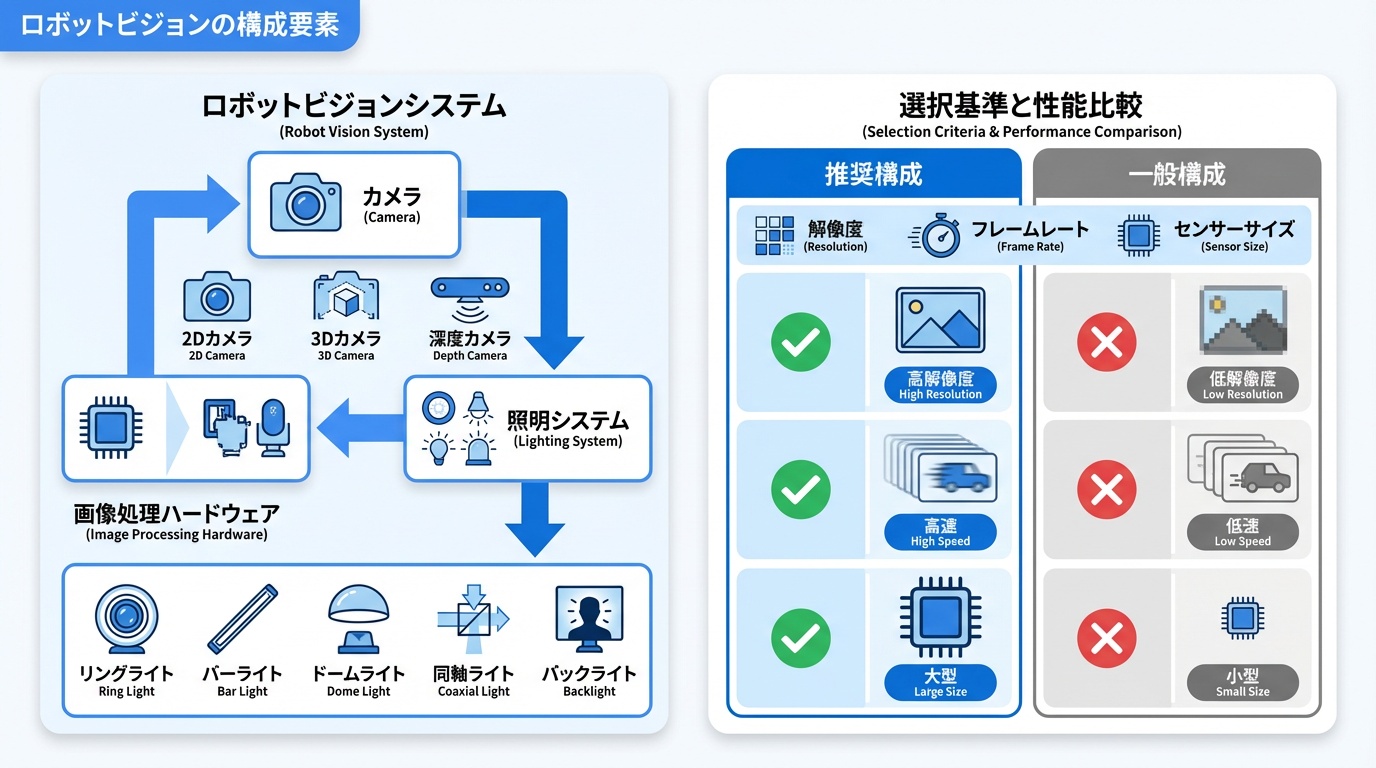

ロボットビジョンの構成要素

ロボットビジョンシステムは、複数のハードウェア・ソフトウェアコンポーネントで構成されています。各要素の役割と選定ポイントを解説します。

カメラ(2Dカメラ、3Dカメラ、デプスカメラ)

ロボットビジョンの「目」となるカメラは、用途に応じて適切なタイプを選択する必要があります。

| カメラタイプ | 特徴 | 主な用途 | 価格帯 |

|---|---|---|---|

| 2Dカメラ | 平面画像を取得、高解像度 | 外観検査、文字認識 | 数万〜数十万円 |

| 3Dカメラ(ステレオ) | 2台のカメラで奥行き算出 | ピッキング、位置計測 | 数十万〜100万円 |

| デプスカメラ(ToF) | 光の飛行時間で距離計測 | ロボットナビゲーション | 数万〜数十万円 |

| 構造化光カメラ | パターン投影で3D形状取得 | 高精度3D計測 | 数十万〜数百万円 |

産業用途では、エリアスキャンカメラ(面で撮影)とラインスキャンカメラ(線で撮影、ベルトコンベア用)の使い分けも重要です。解像度、フレームレート、センサーサイズなどのスペックは、対象物のサイズや処理速度要件に応じて選定します。

照明システム

画像認識の精度は照明条件に大きく左右されます。適切な照明設計は、ロボットビジョンシステム成功の鍵となります。

- リング照明:カメラ周囲から均一に照射、反射の少ない対象物向け

- バー照明:線状に照射、エッジ検出や表面検査向け

- ドーム照明:拡散光で均一照明、光沢面の撮影向け

- 同軸落射照明:カメラ軸と同軸で照射、鏡面・透明体向け

- バックライト照明:対象物の背面から照射、輪郭・シルエット検出向け

AINOW編集部

|

照明選定は「カメラ選定より重要」と言われることもあります。まずはサンプル評価で最適な照明を見極めましょう。 |

画像処理ハードウェア

取得した画像データを高速に処理するためのハードウェアも重要な構成要素です。

- 産業用PC:汎用性が高く、複雑な処理に対応。ファンレス設計が主流

- 組込みボード:NVIDIA Jetsonシリーズなど、エッジAI処理に最適

- スマートカメラ:カメラと処理ユニットが一体化、省スペース

- FPGA:超高速・低遅延処理が必要な場合に選択

- 専用ビジョンコントローラ:Cognex、Keyenceなどの専用ハードウェア

近年はエッジAIの発展により、カメラ側でディープラーニング推論を行うスマートカメラが増加しています。

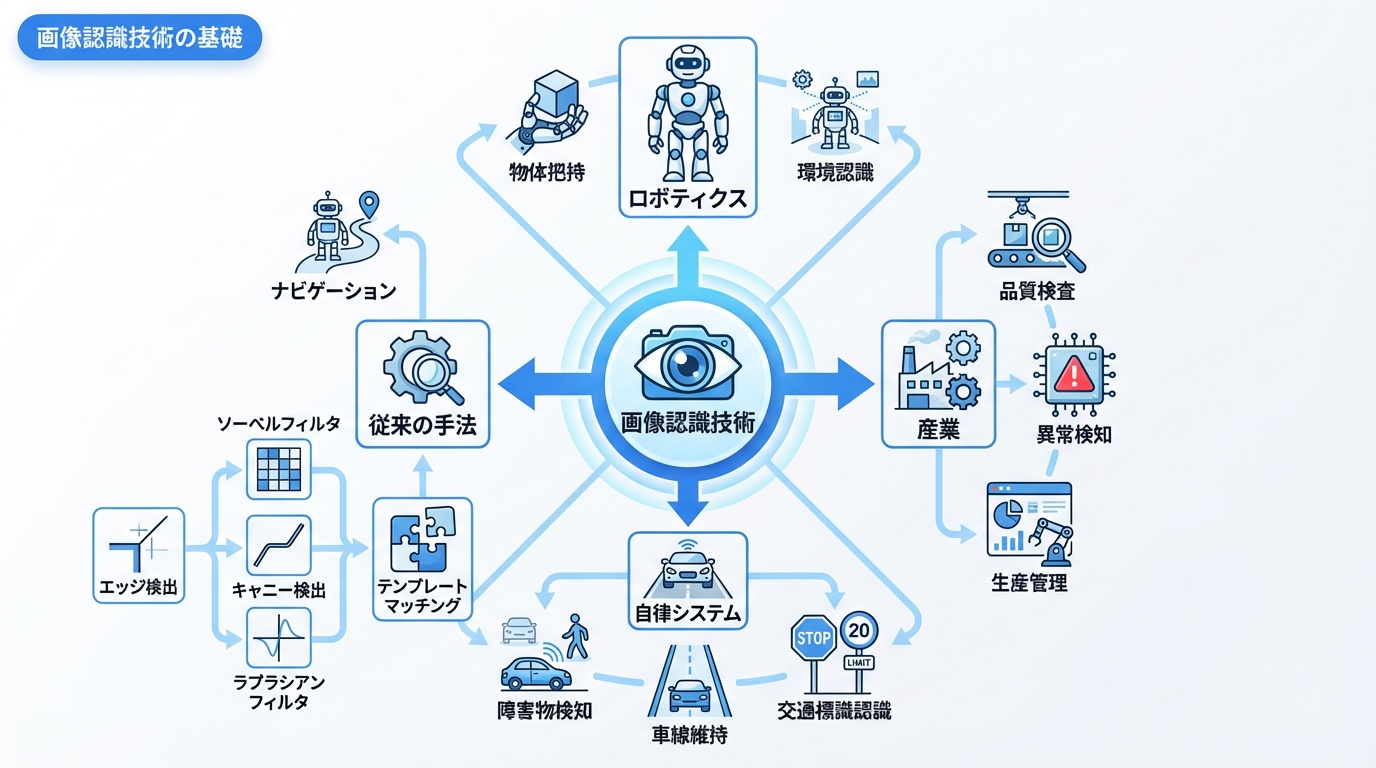

画像認識技術の基礎

ロボットビジョンの核となる画像認識技術について、従来型手法とディープラーニング手法の両面から解説します。

従来型画像処理(エッジ検出、テンプレートマッチング)

ディープラーニング登場以前から使われてきた古典的な画像処理手法は、現在でも多くの産業用途で活用されています。

エッジ検出

画像内の輪郭・境界線を検出する手法です。代表的なアルゴリズムとして以下があります。

- Sobelフィルタ:微分演算によりエッジ強度と方向を検出

- Cannyエッジ検出:ノイズ除去、勾配計算、非極大抑制を組み合わせた高精度手法

- Laplacianフィルタ:2次微分によるエッジ検出

テンプレートマッチング

事前に登録したテンプレート画像と入力画像を照合し、対象物の位置を特定します。正規化相互相関(NCC)や位相限定相関(POC)などの手法が使われます。

ブロブ解析

二値化した画像から連結領域(ブロブ)を抽出し、面積・重心・形状特徴を計算します。部品のカウントや位置検出に有効です。

ディープラーニングによる画像認識

2012年以降、畳み込みニューラルネットワーク(CNN)を用いたディープラーニング手法が画像認識の精度を飛躍的に向上させました。

| 項目 | 従来型画像処理 | ディープラーニング |

|---|---|---|

| 特徴量設計 | 人手で設計 | 自動学習 |

| 対応力 | 想定内の変動のみ | 多様な変動に対応 |

| 学習データ | 不要 | 大量のデータが必要 |

| 処理速度 | 高速 | GPUで高速化可能 |

| 解釈性 | 高い | ブラックボックス |

| 導入コスト | 低い | 学習環境が必要 |

産業用途では、従来型手法の安定性・解釈性と、ディープラーニングの柔軟性を組み合わせたハイブリッドアプローチが増えています。

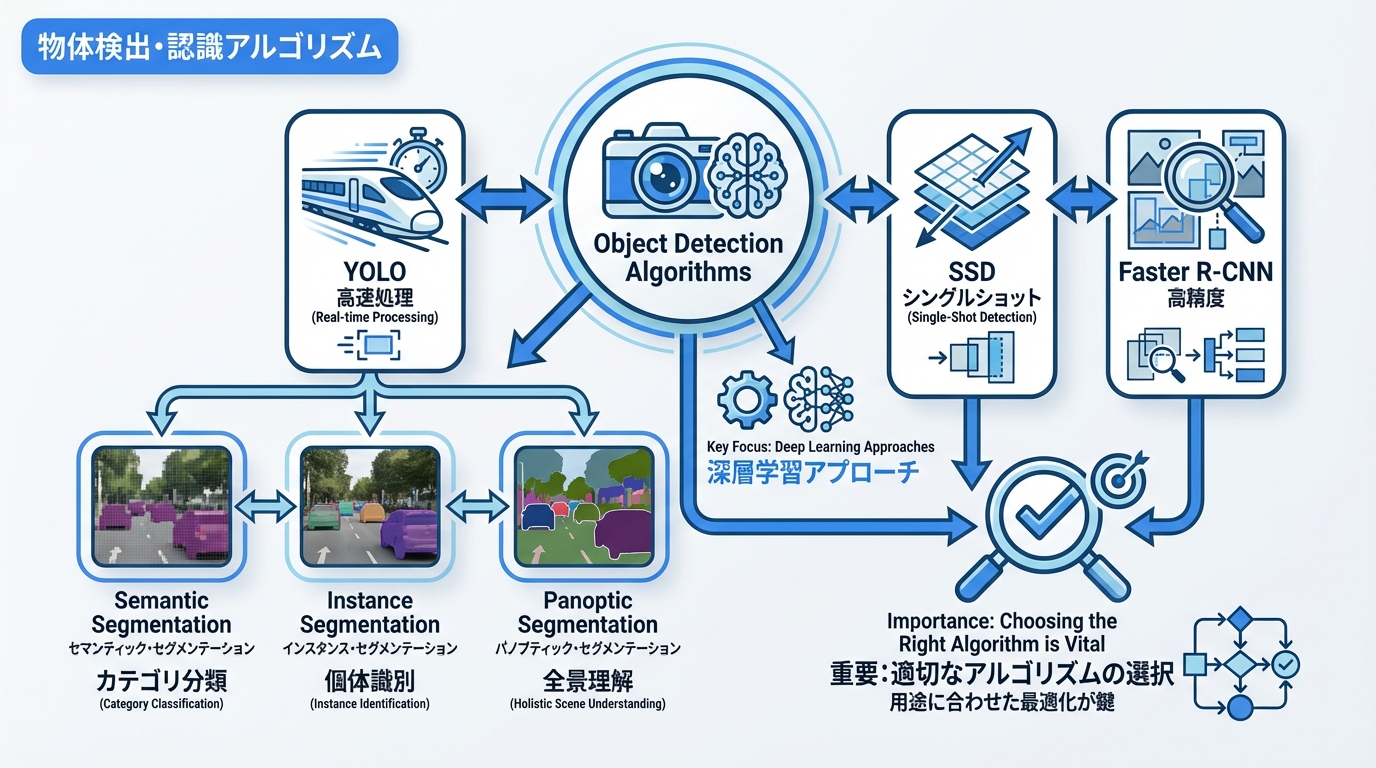

物体検出・認識アルゴリズム

ロボットビジョンで使用される主要な物体検出アルゴリズムを解説します。用途に応じた適切な選択が重要です。

YOLO、SSD、Faster R-CNN

ディープラーニングベースの物体検出アルゴリズムは、大きく2つのアプローチに分類されます。

1ステージ検出器(YOLO、SSD)

画像全体を一度に処理し、物体の位置とクラスを同時に予測します。高速処理が可能で、リアルタイム用途に適しています。

| アルゴリズム | 特徴 | 速度 | 精度 | 推奨用途 |

|---|---|---|---|---|

| YOLOv8 | 最新版、高速・高精度のバランス | ◎ | ○ | リアルタイムピッキング |

| YOLOv10 | 2024年発表、NMS不要で高速化 | ◎ | ◎ | エッジデバイス向け |

| SSD | マルチスケール検出 | ◎ | ○ | 組込み用途 |

2ステージ検出器(Faster R-CNN)

まず物体の候補領域を抽出し、次にその領域を詳細に分類します。処理時間は長くなりますが、高精度な検出が可能です。

AINOW編集部

|

産業用途では速度と精度のトレードオフを考慮してください。検査工程はFaster R-CNN、ピッキングはYOLOが適しています。 |

セグメンテーション技術

物体検出の発展形として、画像をピクセル単位で分類するセグメンテーション技術があります。

- セマンティックセグメンテーション:画像全体のピクセルをクラスごとに分類

- インスタンスセグメンテーション:同一クラス内の個別物体を区別して分類

- パノプティックセグメンテーション:セマンティックとインスタンスを統合

代表的なモデルとして、Mask R-CNN、Segment Anything Model(SAM)などがあります。SAMは2023年にMetaが発表した汎用セグメンテーションモデルで、産業用途への応用も進んでいます。

3Dビジョン技術

ロボットが3次元空間で正確に動作するためには、3Dビジョン技術が不可欠です。主要な3D計測手法を解説します。

ステレオビジョン

人間の両眼視のように、2台のカメラで同一対象を撮影し、視差(視点の違いによる位置のずれ)から奥行きを算出する手法です。

|

産業用ステレオカメラとして、Photoneo、Zivid、SICK Visionary-Sなどが広く使われています。

ToFセンサー、LiDAR

ToF(Time of Flight)センサーは、光(赤外線レーザー)を対象物に照射し、反射して戻ってくるまでの時間から距離を計測します。

- 直接ToF:パルス光の飛行時間を直接計測。長距離向け

- 間接ToF:変調光の位相差から距離算出。近距離・高精度

LiDAR(Light Detection and Ranging)は、レーザーを走査して広範囲の3D点群を取得します。自律移動ロボット(AMR)や自動運転車で広く採用されています。ロボットセンサーの詳細はこちらで解説しています。

構造化光

既知のパターン(縞模様、格子、ドットなど)を対象物に投影し、その変形から3D形状を復元する手法です。

- 縞投影法:正弦波縞を投影し、位相シフトで高精度計測

- ランダムドットパターン:Microsoft Kinect、Intel RealSenseで採用

高精度な3D計測が可能ですが、外乱光の影響を受けやすいため、照明環境の制御が重要です。

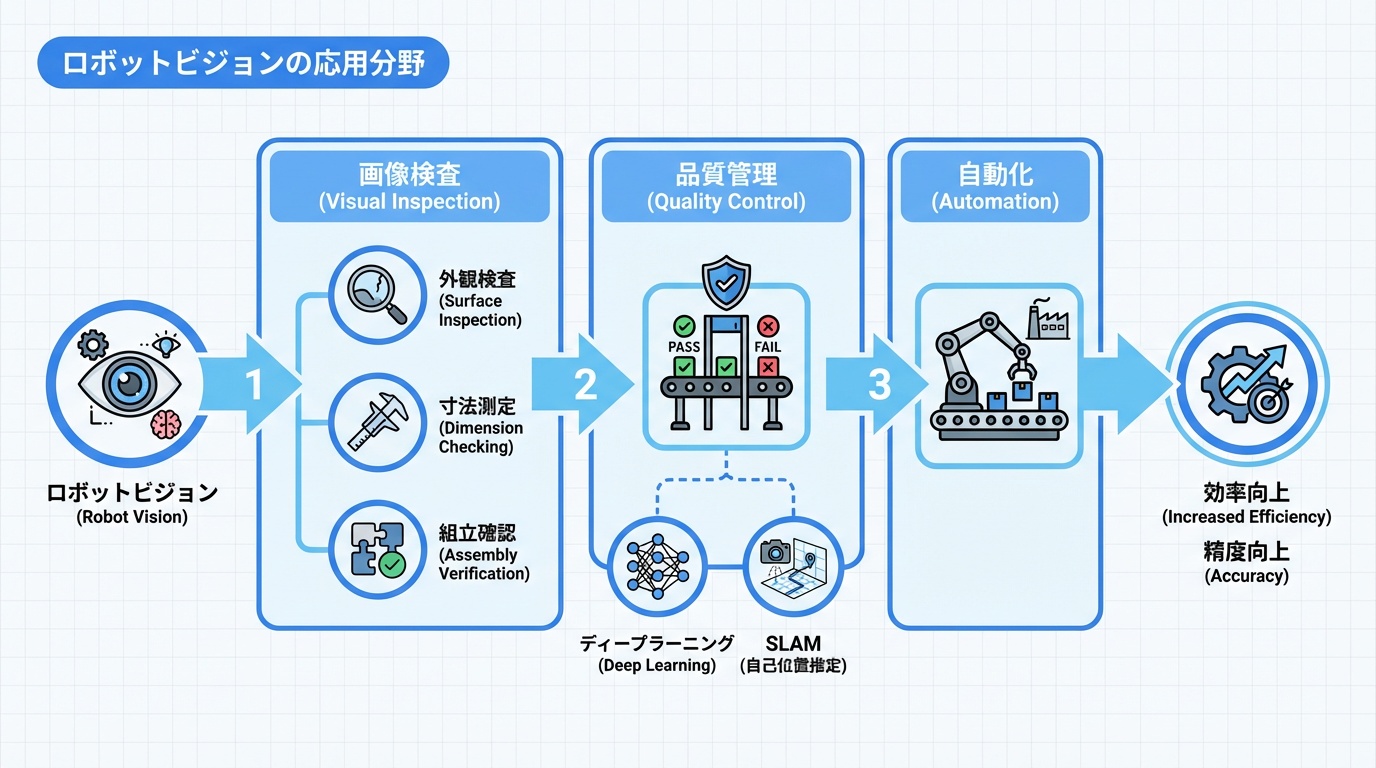

ロボットビジョンの応用分野

ロボットビジョンは製造業を中心に、多様な分野で実用化されています。代表的な応用分野を紹介します。

外観検査

製品の傷、汚れ、欠陥、寸法異常などを自動検出する用途です。品質管理の自動化・効率化に貢献しています。

- 表面検査:金属、ガラス、フィルムの微細な傷・ムラを検出

- 寸法検査:部品の形状・サイズが規格内かを判定

- 組立検査:部品の有無、向き、位置ずれを確認

- 印字検査:ラベル、日付、ロット番号の読み取り・照合

ディープラーニングの導入により、従来は人間の目視に頼っていた複雑な外観検査の自動化が進んでいます。

ピック&プレイス

ロボットアームで対象物を把持(ピック)し、指定位置に配置(プレイス)する作業です。物流、製造組立で広く活用されています。

| ピッキングタイプ | 説明 | 難易度 |

|---|---|---|

| 整列ピッキング | トレイ上に整列した部品を取り出す | 低 |

| バラ積みピッキング | 箱内にランダムに積まれた部品を取り出す | 高 |

| 混載ピッキング | 複数種類の部品が混在する中から選別 | 最高 |

バラ積みピッキング(ビンピッキング)は3Dビジョンとの組み合わせが必須であり、ロボットマニピュレーション技術の進化とともに実用化が進んでいます。

自律移動ロボット

AMR(Autonomous Mobile Robot)やAGV(Automated Guided Vehicle)における環境認識・障害物回避にロボットビジョンが活用されています。

- SLAM:Simultaneous Localization and Mapping。自己位置推定と環境地図作成を同時に行う

- 障害物検出:人、台車、落下物などを検出して回避

- 経路計画:最適な移動経路をリアルタイムで算出

AINOW編集部

|

物流倉庫でのAMR導入が急速に進んでいます。ビジョンとLiDARの併用で安全性と効率性を両立しています。 |

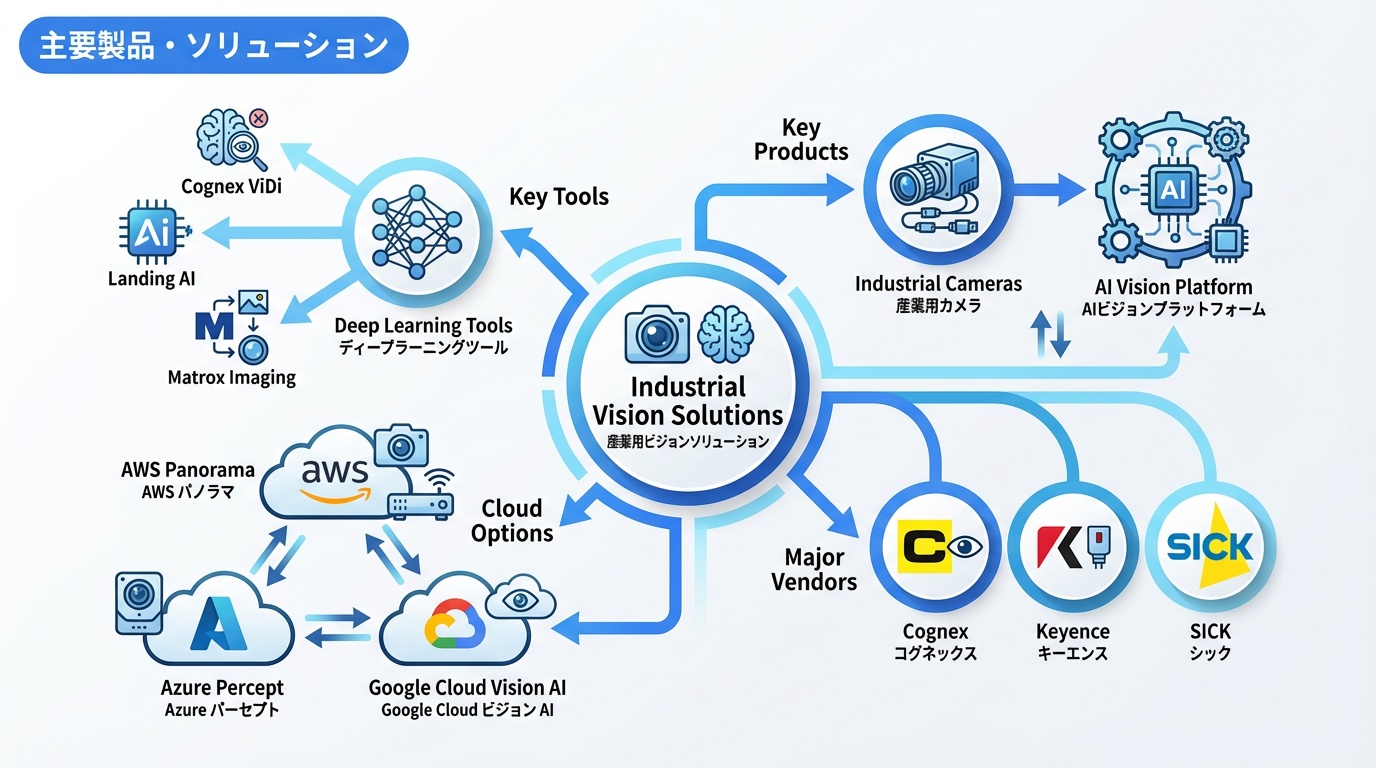

主要製品・ソリューション

ロボットビジョン分野の主要ベンダーと製品を紹介します。

産業用カメラ(Cognex、Keyence、SICK)

| メーカー | 主力製品 | 特徴 | 強み |

|---|---|---|---|

| Cognex | In-Sight、DataMan | AI統合ビジョンシステム | 世界シェアNo.1、豊富な実績 |

| Keyence | CV-X、XG-Xシリーズ | 使いやすいUI、高速処理 | 日本国内サポート充実 |

| SICK | Inspector、Visionary | 3Dビジョン、センサー統合 | 欧州シェア高、安全規格対応 |

| Basler | ace、boost | コストパフォーマンス | 産業用カメラ専業 |

| OMRON | FH/FZシリーズ | ロボット統合 | 自社ロボットとの連携 |

AIビジョンプラットフォーム

ディープラーニングを活用したAIビジョンプラットフォームが増加しています。

- Cognex ViDi:産業用途に特化したディープラーニングツール

- Landing AI:Andrew Ng創設、製造業向けAI

- Matrox Imaging:ハードウェア・ソフトウェア統合ソリューション

- MVTec HALCON:老舗の画像処理ライブラリ、AI機能拡充

- OpenCV + TensorFlow/PyTorch:オープンソースの組み合わせ

クラウドベースのAIビジョンサービス(AWS Panorama、Azure Percept、Google Cloud Vision AI)も選択肢として検討できます。

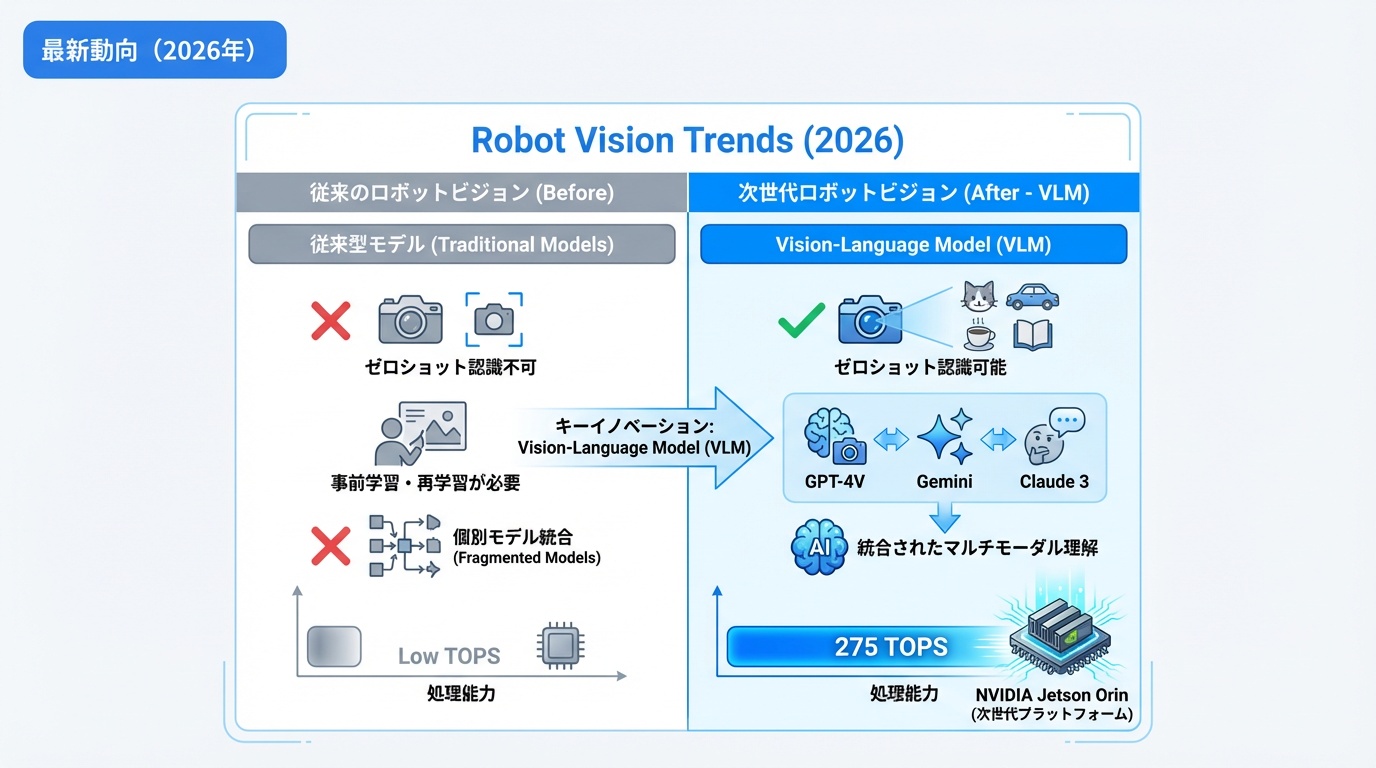

最新動向(2026年)

2026年現在のロボットビジョン分野における最新技術トレンドを解説します。

生成AIとビジョンの融合

大規模言語モデル(LLM)と視覚モデルを統合したVision-Language Model(VLM)がロボットビジョンに革新をもたらしています。

- ゼロショット認識:事前学習なしで新しい物体を認識

- 自然言語指示:「赤い箱を取って」などの自然言語でロボットを操作

- 異常検知の高度化:「通常と異なる状態」を言語で説明可能

GPT-4V、Gemini、Claude 3などのマルチモーダルAIを産業用途に応用する研究・実装が加速しています。NVIDIAのIsaac SimとLLMの統合も注目されています。

AINOW編集部

|

VLMの産業応用は2025年後半から実用フェーズに入りました。導入検討は今がベストタイミングです。 |

エッジAIビジョン

クラウドに頼らず、カメラ・デバイス側でAI推論を行うエッジAIビジョンが主流になりつつあります。

- NVIDIA Jetson Orin:275 TOPSの処理能力、産業用エッジAIの定番

- Intel Core Ultra + NPU:AI PC向け、ローカルLLM対応

- Hailo-8:低消費電力の汎用AIアクセラレータ

- Google Coral:TensorFlow Lite最適化、低コスト

エッジ処理により、レイテンシー削減、プライバシー保護、通信コスト削減が実現できます。詳しくはエッジAIガイドをご覧ください。

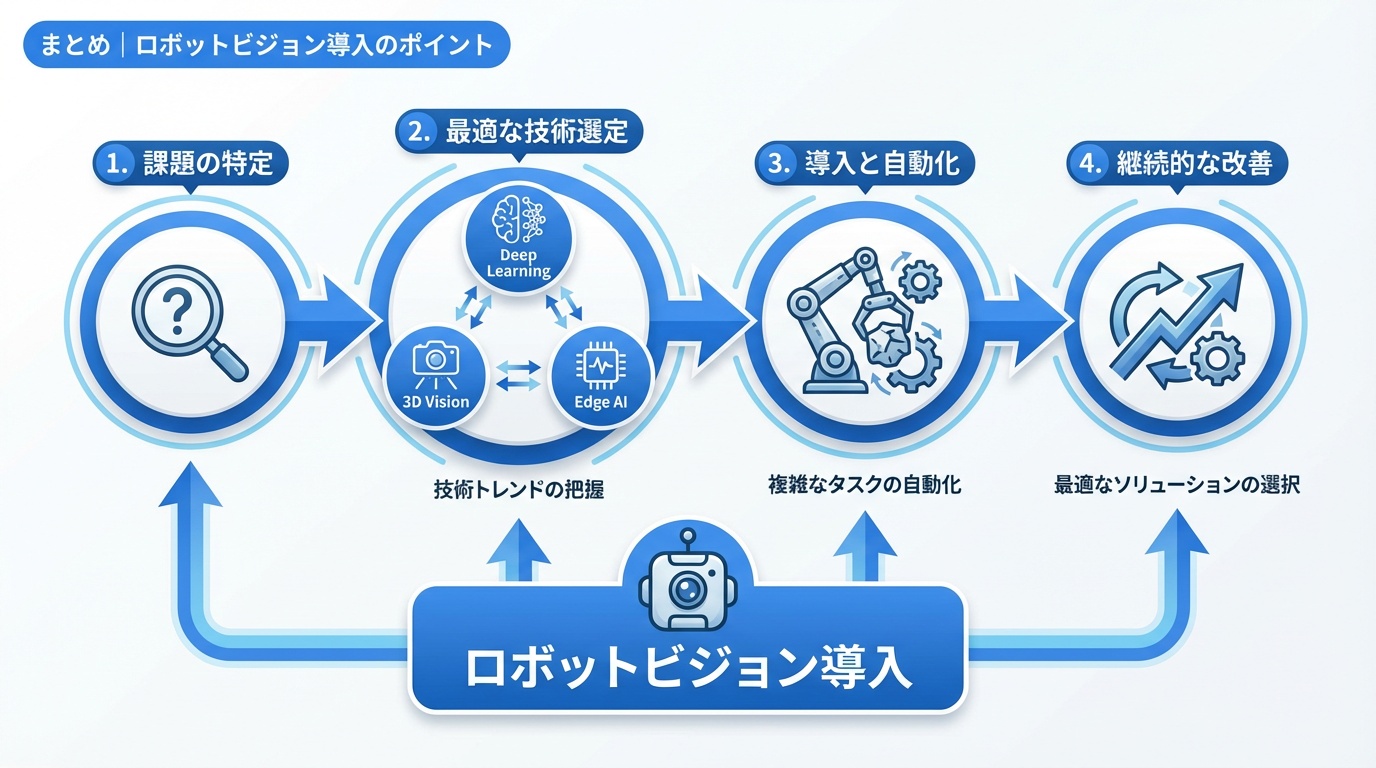

まとめ|ロボットビジョン導入のポイント

ロボットビジョンは、製造業の自動化・省人化を支える重要な基盤技術です。2026年現在、ディープラーニング、3Dビジョン、生成AI、エッジAIの融合により、従来は困難だった複雑なタスクの自動化が実現可能になっています。

導入を検討する際は、以下のポイントを押さえておきましょう。

|

ロボットビジョン技術は急速に進化しており、数年前には困難だった課題も現在では解決可能になっていることが少なくありません。最新の技術動向をキャッチアップしながら、自社の課題に最適なソリューションを選定することが成功の鍵となります。

よくある質問

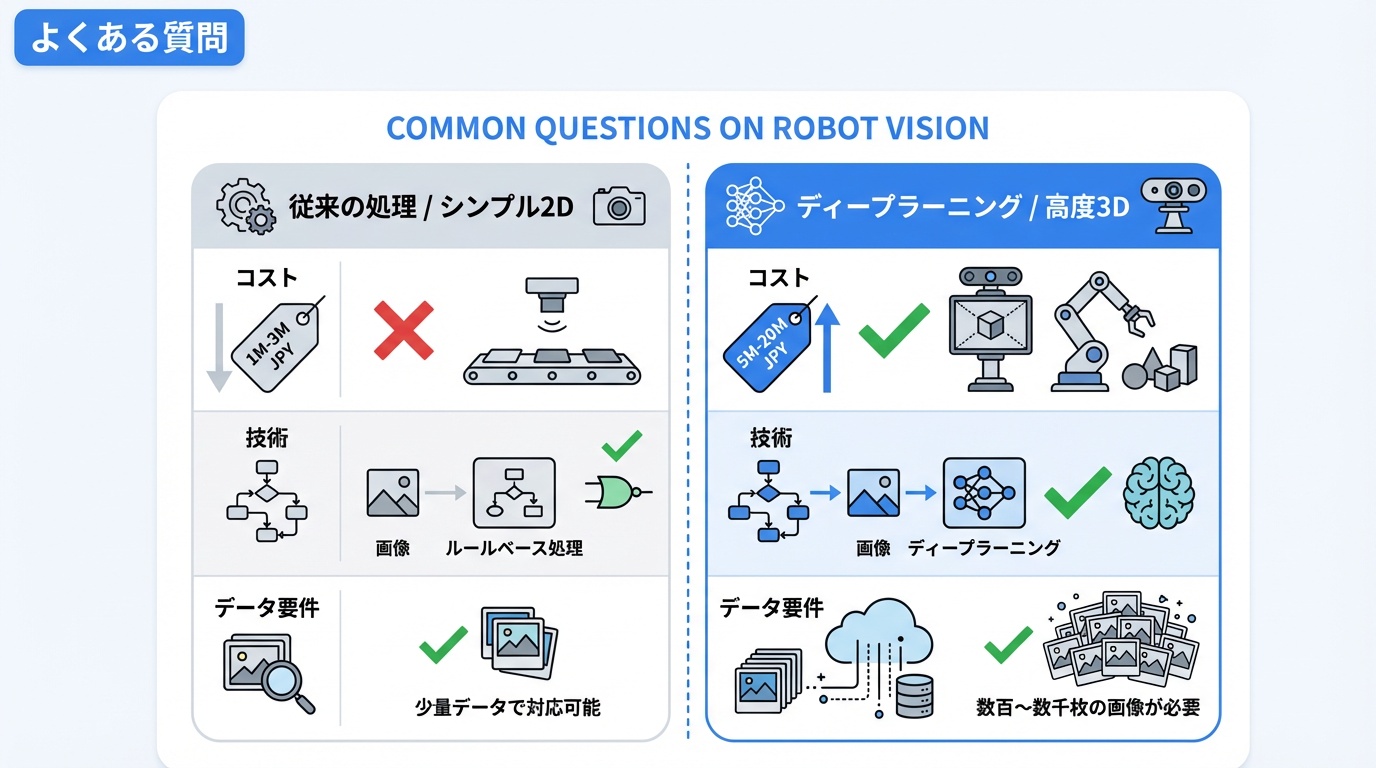

Q. ロボットビジョンの導入コストはどのくらいですか?

A. 用途と規模により大きく異なります。シンプルな2D検査システムは100〜300万円程度、3Dビジョン+ロボットアームのピッキングシステムは500万〜2,000万円程度が目安です。PoC段階ではレンタルやサブスクリプションの活用も検討しましょう。

Q. ディープラーニングと従来型画像処理、どちらを選ぶべきですか?

A. 対象物の変動が少なく、検査基準が明確な場合は従来型が適しています。変動が大きい、言語化しにくい欠陥を検出したい場合はディープラーニングが有効です。多くのケースでは両者を組み合わせたハイブリッドアプローチが採用されています。

Q. 学習データはどのくらい必要ですか?

A. ディープラーニングの場合、一般的に1クラスあたり数百〜数千枚の画像が必要です。ただし、転移学習やデータ拡張(オーグメンテーション)を活用すれば、より少ないデータで実用的な精度を達成できることもあります。

Q. 外乱光の影響を軽減するにはどうすればよいですか?

A. 照明の囲い込み(暗箱化)、波長フィルターの使用、パルス照明と同期撮影などの対策が有効です。設置環境の照明条件を事前に調査し、照明メーカーと相談しながら最適な構成を検討してください。

Q. エッジAIとクラウドAI、どちらを選ぶべきですか?

A. リアルタイム性(10ms以下の応答)が必要、プライバシーが重要、ネットワーク接続が不安定な場合はエッジAIが適しています。大量データの分析、モデルの一元管理が重要な場合はクラウドAIが有利です。多くの産業用途ではエッジで推論、クラウドで学習・管理というハイブリッド構成が採用されています。

https://ainow.jp/robot-sensor-guide/

https://ainow.jp/food-processing-robot-guide/

GitHub Copilot

GitHub Copilot Replit Agent

Replit Agent Cline

Cline Dify

Dify Jinbaflow

Jinbaflow