AINow(エーアイナウ)編集部です。本記事では、近年、人工知能技術の躍進とともに注目を集めるLangChainについて、基本概念から実践的な利用法、さらにはChatGPTなどの生成AIとの連携方法まで、幅広くそして実践的に解説しています。LangChainの仕組みや構成要素、利用例を通じて、AIアプリケーションの開発における新たな可能性を理解し、業務効率化や革新的なサービス実現に役立てるための具体的な情報が得られるでしょう。

本記事の内容を学ぶことで、生成AIの基本的な知識の習得はもちろん、ChatGPTの活用や企業の生成AI活用事例、さらにはRAG技術など、最新のAI動向を踏まえた実装方法や運用上のポイントが身につきます。そのため、初心者だけでなく、現場で実際にAIを導入しているエンジニアや企業担当者にとっても非常に有用な情報となるでしょう。

LangChainとは何か

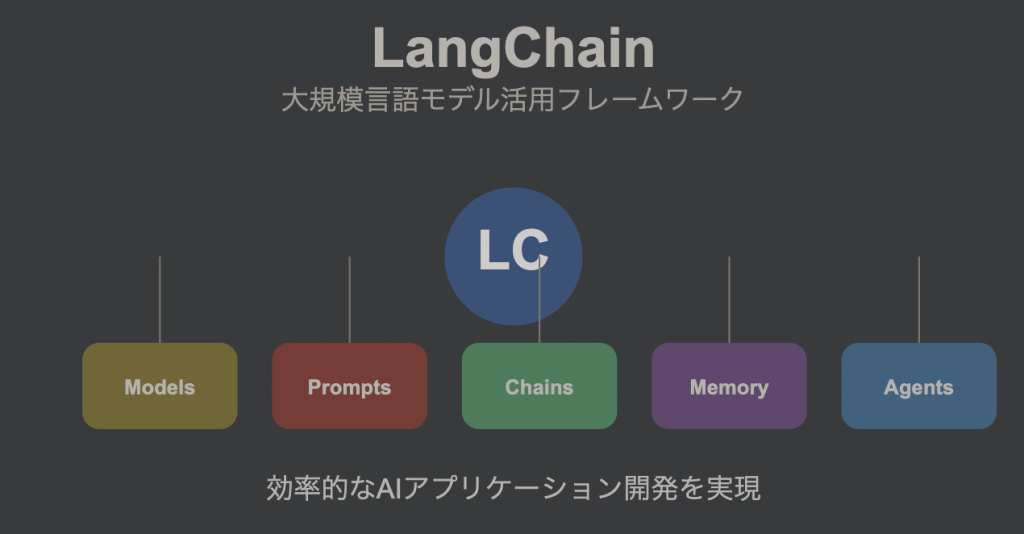

LangChainは、大規模言語モデル(LLM)を効率的に活用し、柔軟で高度なAIアプリケーションの開発を支援するためのオープンソースフレームワークです。2025年8月現在、多くの開発者やAIエンジニアに支持され、業界をリードする技術として幅広く導入されています。LangChainの特徴として、異なるLLMや外部ツールとの連携の柔軟性が挙げられ、たとえばChatGPTをはじめとする生成AIとの融合により、より複雑なタスクもシンプルに実現可能です。

本記事では、LangChainの基本概念、実装方法、具体的な構造までを網羅的に解説し、導入にあたっての留意点や最新の業界動向にも触れています。さらに、LangChainがどのようにして他の生成AI技術と連携し、柔軟かつ拡張性の高いシステムを実現するのか、詳細にご紹介します。

LangChainの基本概念と特徴

LangChainの概要

LangChainは、LLMの能力を最大限に引き出し、実際のビジネスや研究課題に応用するために設計された多機能フレームワークです。このフレームワークは、複数のモジュールが連携し、各種LLMとの相互運用性を実現しています。すなわち、OpenAIのGPT-3/4、Google PaLM、Hugging Faceなど、多種多様なモデルを統合して利用できる点が大きなメリットとなっています。

筆者の経験からも、プロジェクトにおいて複数のモデルを柔軟に入れ替える必要がある際に、このLangChainが極めて有用であると感じました。

LangChainの強みは、各機能がモジュール方式で設計されているため、必要な機能のみを選択的に組み合わせられる点にあります。具体的には、プロンプト管理やチェイン機能、メモリ管理、エージェント機能など、システム開発における各フェーズに対応した豊富な機能が用意されており、柔軟性と拡張性を兼ね備えています。これにより、企業内の業務自動化や高度な意思決定支援システムの構築にも十分対応できます。

LangChainの主な特徴

LangChainは、次の各特徴を組み合わせることで、単純なチャットボットから複雑な意思決定システムまで、幅広いAIアプリケーションの開発を可能にします。まず、各種LLMのサポートは、多様なモデルとの柔軟な連携を可能にし、使用するタスクに合わせた最適なモデル選択が行えます。さらに、プロンプト管理機能により効果的な入力設計ができ、チェイン機能では複数処理ステップを連結して高度なワークフローを実現。

また、メモリ機能は文脈に沿った対話の維持をサポートし、エージェント機能は自律的なタスク実行を可能にするため、実際の業務に直結するシステムの実現が可能です。

これらの機能は、従来の静的なAIアプローチに比べ動的かつ柔軟な対応が必要な現代のビジネス環境において大きなアドバンテージとなっています。たとえば、Stable Diffusionなど画像生成の技術と組み合わせることで、生成AIの新たな可能性が広がります。このようにLangChainは、業界全体のトレンドに敏感な最新技術の統合と、それに基づいたアプリケーション開発を強力にサポートするツールとして注目を浴びています。

LangChainの柔軟性と拡張性

LangChainの柔軟性は、多様なLLMや外部API、さらには独自のカスタムコンポーネントとの容易な統合にあります。この仕組みにより、開発者は特定のタスクに最適なシステムを構築できるだけでなく、将来的な技術進化にも柔軟に対応可能です。具体的には、従来の静的な処理から、リアルタイムなデータ連携や自律的なタスク管理へとシフトする現代のニーズに応えられるため、幅広い業種において即戦力として利用できる点が大きな特徴です。

筆者自身も、プロジェクトにおける試行錯誤を通して、この拡張性の高さに強く感銘を受けています。たとえば、Azure生成AIやMicrosoft生成AIとの連携により、最新のクラウド技術基盤を利用したアプリケーション開発にも役立っています。

LangChainの構成要素

LangChainは複数の主要なコンポーネントの集合体であり、各構成要素が連携することで、先進的かつ柔軟なAIアプリケーションの開発を実現します。ここでは、各コンポーネントがどのような役割を持ち、どのような特徴があるのかを詳しく解説し、具体的なユースケースや動作例を交えて説明していきます。これにより、読者はLangChainの内部構造を深く理解し、実際のシステム設計に役立てる知識を得られるはずです。

Models(モデル)

Modelsコンポーネントは、LangChainの中核を担う部分であり、実際にテキスト生成、要約、翻訳など多方面のタスクを実行するための各種LLMを管理します。代表的なものとして、OpenAIのGPT-3/4、Google PaLM、Hugging Faceのモデルなどがあり、利用するプロジェクトに合わせた最適なモデルを手軽に選択できます。さらに、モデルごとにパラメータ調整を行うことが可能で、たとえば温度や最大トークン数などを設定することで、用途に合わせた柔軟な出力生成が実現されます。

実際、各LLMの特性を理解しつつ、生成AIの基本と応用技術を組み合わせることで、より精度の高いシステムを構築できる点は大きな魅力です。各種内部リンクを活用して、生成AIの基本から最新トレンドまで、幅広い情報を参照するとよいでしょう。

Prompts(プロンプト)

Promptsコンポーネントは、LLMに対する適切な入力文を設計・管理するための重要な役割を担います。プロンプトは、その出力品質に直結するため、テンプレート化や動的生成が可能なLangChainならではの機能となっています。具体的には、定型文を用いたプロンプトの管理や、状況に応じた入力文の自動生成、さらには最適化による出力精度の向上などが含まれます。

これにより、ユーザーの入力に即した柔軟な応答が可能になり、より自然なインタラクションが実現されるのです。たとえば、チャットボットやFAQシステムにおいて、ユーザーの質問のニュアンスに沿った回答を生成することで、その精度とユーザビリティを大幅に向上させることができるため、実用性の高いツールと言えるでしょう。

Chains(チェイン)

Chainsコンポーネントは、複数のLLMや処理ステップを論理的に連結し、全体として一貫したタスク実行を行うための仕組みです。これにより、単一のモデルでは実現が困難な複雑なタスクを、段階的に処理することが可能となります。たとえば、入力の解析、応答生成、結果の統合といった複数のステップを連続して実行することで、より高精度なアウトプットや、エラー発生時のリカバリを実現。

Chainの設計により、システム全体の制御性が向上し、業務プロセスの自動化や高度な意思決定支援が可能となります。実際、Chainを活用したワークフローの設計方法は、企業の生成AI活用事例としても多く取り上げられており、業務効率化やコスト削減につながるケースも少なくありません。

Memory(メモリ)

Memoryコンポーネントは、対話システムや連続タスクにおいて、過去の会話履歴や重要情報を保持・活用する役割を担います。これにより、システムはコンテキストを維持し、より一貫した応答を生成できるようになります。具体的には、会話記録のバッファリングや、履歴情報を元にした応答制御が行われ、ユーザーとの長期的な対話が可能となります。

プロジェクトによっては、複数のセッション間にわたってデータを共有し、よりパーソナライズされたサービスの提供にも役立ちます。こうした機能は、たとえば、企業内のチャットボットによるサポート業務において、従業員の過去の問い合わせ内容を踏まえた返答や、エージェントシステムで実現される自律的な業務判断など、実用的かつ戦略的な価値を発揮する事例が多く、システム全体のユーザビリティ向上に大きく寄与します。

Agents(エージェント)

Agentsコンポーネントは、LangChainの中で自律的なタスク実行や外部ツールとの連携を支える重要な機能です。これにより、システムは人間に近い意思決定プロセスを模倣し、複雑な状況下での柔軟な対処が可能になります。具体的には、エージェントがAPI呼び出しや外部データの取得などを自動で行うことで、タスクの自律実行が実現され、従来の手動プロセスを大幅に効率化する効果があります。

たとえば、オンラインショッピングサイトにおけるカスタマーサポートや、金融システムでのリスク管理など、実環境での応用例も多く、最新のNVIDIA AI技術と連携することで、今後さらに進化した応用領域が期待されています。

Retrieval(リトリーバル)

Retrievalコンポーネントは、外部データソースから関連する情報を効率的に検索し、取得する機能を提供します。この機能により、LLMは最新のデータや特定の情報にアクセスでき、結果としてより正確な応答を生成することが可能になります。具体的には、多様なデータベースやウェブサイト、APIとの接続が容易で、コンテキストに基づく情報抽出が可能となります。

これにより、特に大量のデータ処理が必要な領域、例えば法律、医療、研究などの分野において、詳細な情報検索、さらには複数ソースからの統合が実現され、システム全体の精度と信頼性が向上します。ユーザーは、情報検索の効率と正確性を求める際に、Retrieval機能を活用することで、大量データの中から必要な情報を迅速に把握できる利点を享受できます。

これらの各構成要素を組み合わせることで、LangChainは非常に強力かつ柔軟なAIアプリケーション開発プラットフォームとして機能します。次のセクションでは、LangChainのインストールとセットアップ方法について、具体的な手順を詳細に解説します。

LangChainのインストールとセットアップ方法

LangChainを利用するためには、まず適切なインストールと環境セットアップが必要です。本セクションでは、PythonおよびJavaScript/TypeScriptでの具体的なインストール手順を紹介し、仮想環境の利用や追加パッケージの設定方法についても詳細に説明します。これにより、開発者はすぐにLangChainを動作させ、プロジェクトに取り組むための基盤を整えることができるでしょう。

Pythonでのインストール手順

Python環境におけるLangChainの導入はとてもシンプルです。標準のpipコマンドを用いることで、容易にインストールが可能です。また、プロジェクトごとに依存関係の競合を避けるため、仮想環境を使用することが強く推奨されます。

初めての方でも、以下に示す具体的な手順を順に実行するだけで、環境構築が完了し、すぐにLangChainの機能を試すことが可能です。

- pipを利用しインストール

pip install langchain- 仮想環境の作成(推奨)

python -m venv langchain-env

source langchain-env/bin/activate # Linuxの場合

langchain-env\Scripts\activate # Windowsの場合

pip install langchain- 必要に応じた追加パッケージのインストール

pip install openai # OpenAI GPTモデルを使う場合

pip install google-auth # Google PaLMを利用する場合仮想環境を利用することで、プロジェクト間の依存関係の衝突を防ぎ、安定した開発環境を維持できます。これにより、複数のプロジェクトが同時進行している場合でも、各々が必要とするバージョン管理が可能になるため、安心してLangChainの機能を試すことが可能です。さらに、環境構築の詳細については、GitHub Copilotの利用ガイドも参考にすると良いでしょう。

JavaScriptとTypeScriptでのセットアップ

JavaScriptおよびTypeScript環境でLangChainを利用する場合も、簡潔な手順でセットアップが行えます。npmを活用してパッケージをインストールし、さらにTypeScriptユーザーは型定義ファイルも追加することで、開発効率とコードの安全性が向上します。非同期処理が主となるため、async/await構文を活用する点にも注意が必要ですが、例えば、Microsoft生成AIとの連携といった最新の応用例も活用できるため、最新の技術動向に合わせたセットアップを進めることが期待されます。

具体的な導入手順としては、以下のようになります。これに従って進めれば、すぐにLangChainの各種機能が利用可能となり、開発環境が整います。

- npmによるインストール

npm install langchain- TypeScriptプロジェクトの場合、型定義の追加

npm install --save-dev @types/langchain- 追加パッケージのインストール(必要に応じて)

npm install openai # OpenAI GPTモデル利用の場合

npm install @google-cloud/ai-platform # Google PaLM利用の場合JavaScript/TypeScript環境でLangChainを利用する際は、非同期処理やエラーハンドリングの実装に注意しながらコードを書くことが重要です。こうした実践的な知識は、後のセクションで説明する基本的なChainの作成方法や実行手順とも密接に関わっています。

基本的な設定ファイルの作成

LangChainを効果的に利用するためには、APIキーなどの機密情報を安全に管理することが不可欠です。そこで、環境変数を利用して設定ファイルを作成し、セキュリティと利便性を両立した設定管理を実現します。以下のPythonコードは、.envファイルから環境変数を読み込み、LangChainの基本設定を定義する例ですが、実際の開発現場でも頻繁に利用されている手法です。

設定ファイルを正しく整備することで、後々のトラブルシューティングを回避し、安定したシステム運用が可能となります。

# config.py

import os

from dotenv import load_dotenv

load_dotenv() # .envファイルから環境変数を読み込む

OPENAI_API_KEY = os.getenv("OPENAI_API_KEY")

GOOGLE_API_KEY = os.getenv("GOOGLE_API_KEY")

# LangChainの設定

LANGCHAIN_CONFIG = {

"default_model": "gpt-3.5-turbo",

"temperature": 0.7,

"max_tokens": 150

}この設定例では、APIキーなどの機密情報をコードに直接記述するリスクを低減するため、環境変数として管理する方法を採用しています。これにより、セキュリティとメンテナンス性を両立し、複雑なシステムを効率的に開発するベースラインを確立できます。

また、内部リンクとしてCode aiのおすすめツールとメリット・デメリットも合わせて参照することで、開発効率を高めるための補助ツールや最新技術の選定に役立ちます。次のセクションでは、LangChainの具体的な使い方について詳しく解説していきます。

LangChainの使い方

LangChainを最大限に活用するためには、その基本的な使い方を理解し、実際のプロジェクトに応用できる知識を身につけることが重要です。ここでは、基本的なChainの作成方法から、適切なLLMの選定、プロンプトの構造、Chainの実行に至るまで、具体例を交えながら順を追って解説します。各ステップの詳細な説明を通じて、実際のAIシステム構築で直面する課題や注意点にも触れていきます。

基本的なChainの作成方法

LangChainにおいてChainは、複数の処理ステップを連結し、一連のタスクを自動化するための基本ユニットです。具体的なChainの作成手順としては、まず必要なモジュールのインポート、続いてプロンプトテンプレートの定義、LLMの初期化、そしてChainの構築と実行という流れになります。これにより、入力されたテーマに対して対話的または自律的な出力を得ることができ、業務プロセスの自動化やユーザーインタラクションの向上が期待されます。

各工程においてエラーチェックや検証を行うことで、より堅牢なシステムが構築できる点も、LangChainの実践的な強みです。

from langchain import LLMChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

# プロンプトテンプレートの定義

prompt_template = PromptTemplate(

input_variables=["topic"],

template="Tell me a joke about {topic}."

)

# LLMの初期化

llm = OpenAI(temperature=0.7)

# Chainの作成

chain = LLMChain(llm=llm, prompt=prompt_template)

# Chainの実行

result = chain.run("artificial intelligence")

print(result)この基本的なChain作成の例は、シンプルなタスクからスタートし、実際のシステムにおける拡張が容易である点に注目してください。プロジェクトに応じてプロンプトやモデルのパラメータを調整することで、より複雑なタスクにも対応可能となります。こうした応用例を参考にして、ぜひ自身のプロジェクトでLangChainの可能性を検証してください。

LLMの選定と読み込み

LangChainは、さまざまなLLMをサポートしており、プロジェクトの性質や求める性能に応じた最適なモデル選定が重要となります。たとえば、文章生成能力が要求されるタスクではOpenAIのGPTモデル、よりカジュアルなタスクではHugging Faceのモデルなど、用途に応じた選択が可能です。選定の際は、モデルの応答速度や精度、運用コストなどを総合して判断する必要があります。

こうした点を踏まえることで、プロジェクトにおけるパフォーマンスの最適化が図られ、実践的な運用が実現されます。実際のユースケースを参考にしながら、最適なLLM選定手法を模索してください。

from langchain.llms import OpenAI

llm = OpenAI(model_name="text-davinci-003", temperature=0.7)from langchain.llms import HuggingFacePipeline

llm = HuggingFacePipeline.from_model_id(

model_id="gpt2",

task="text-generation",

model_kwargs={"temperature": 0.7, "max_length": 64}

)from langchain.llms import GooglePalm

llm = GooglePalm(google_api_key="YOUR_API_KEY")LLMの適切な選択と設定は、タスクの特性、必要な性能、ならびに予算と利用リソースを考慮して行う必要があります。ここで示した例は一例に過ぎず、実際のプロジェクトに合わせて最適なモデルを組み合わせ、運用してください。最新情報として、ChatGPT 5.0の新機能と性能のレビューなど、業界動向を参考にするのも良いでしょう。

プロンプトの構築と最適化

効果的なプロンプトの構築は、LLMから高品質な応答を引き出すための根幹です。LangChainは、テンプレートベースのプロンプト作成から、動的生成、組み合わせといった高度な機能を提供し、状況に応じた柔軟な入力設計を可能にします。これにより、ユーザーの意図を的確に反映した入力文を生成でき、結果として出力の精度と多様性が向上します。

試行錯誤を重ねながら、最適なプロンプトの設計が求められるため、実際のユースケースでは、複数のバリエーションを用いて実験することが推奨されます。こうしたプロセスは、システムの正常な運用や応答の統一性確保において非常に価値があります。

from langchain.prompts import PromptTemplate

template = "Write a {adjective} poem about {topic}."

prompt = PromptTemplate(

input_variables=["adjective", "topic"],

template=template

)from langchain.prompts import ChatPromptTemplate, HumanMessagePromptTemplate

human_template = "Write a {adjective} poem about {topic}."

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([human_message_prompt])def generate_prompt(context):

if context == "formal":

return PromptTemplate(

input_variables=["topic"],

template="Provide a formal analysis of {topic}."

)

else:

return PromptTemplate(

input_variables=["topic"],

template="Give me a casual explanation of {topic}."

)プロンプトの最適化は、テストとフィードバックサイクルを通して長期的に改善されるプロセスです。状況に応じて複数のプロンプトを用意し、出力結果を比較検証することで、最適なパラメータ設定や文言の調整を実現できます。これにより、ユーザーが直面する様々なシナリオに対して柔軟かつ高精度な応答が可能となり、システム全体の信頼性と有用性が向上します。

Chainの実行手順

Chainの実行はLangChainの利用における中核プロセスであり、準備から実行、さらに非同期処理を通じた応答取得まで、段階的な手順が必要です。各ステップでは、エラーハンドリングやデータの整合性チェックを確実に行いながら処理を進めることが求められます。シンプルなChainの場合と、複数入力に対応した複雑なChainの場合とでは、実装方法が微妙に異なりますが、基本的な流れは共通しており、適切な実装により、システムの安定動作と高速な応答が実現されます。

ここで紹介する手順を参考に、自身のプロジェクトに合わせた最適な実装方法を検討してください。

from langchain import LLMChain

from langchain.llms import OpenAI

from langchain.prompts import PromptTemplate

llm = OpenAI(temperature=0.7)

prompt = PromptTemplate(

input_variables=["product"],

template="What are 5 creative ways to market {product}?"

)

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.run("a new smartphone app")

print(result)multi_input_prompt = PromptTemplate(

input_variables=["product", "target_audience"],

template="Suggest 3 marketing strategies for {product} targeting {target_audience}."

)

multi_input_chain = LLMChain(llm=llm, prompt=multi_input_prompt)

result = multi_input_chain.run(product="electric car", target_audience="millennials")

print(result)import asyncio

async def run_chain_async():

return await chain.arun("a new smartphone app")

result = asyncio.run(run_chain_async())

print(result)Chain実行の際は、特にAPI制限やネットワーク障害などのエラー発生に注意し、適切なエラーハンドリングを行うことが推奨されます。上記の例は基本的な手順ですが、実際の運用においては、デバッグ情報の記録や例外処理、非同期処理の最適化を行うなど、細かな調整が求められます。こうした工夫を重ねることで、実用的で堅牢なAIシステムの構築を実現できるでしょう。

また、Code aiのおすすめツールとメリット・デメリットにおける具体例も参考にし、実際の開発現場での運用方法や注意点を確認すると良いでしょう。

LangChainを利用した具体的なアプリケーション例

LangChainの機能を十分に活用することで、さまざまな革新的なアプリケーションが開発可能です。このセクションでは、企業内のチャットボットやウェブサイト要約ツール、PDF解析システムなど、具体的な実装例を通じて、LangChainがどのように実務に応用されるかを詳しく解説します。実際のコード例や設定方法も紹介しながら、読者が自らのプロジェクトに応用しやすい形で情報を提供することを目指しています。

社内チャットボットの導入

企業内での効率的な情報共有や問い合わせ対応のために、LangChainを活用した社内チャットボットは非常に有効です。社内ルールやFAQ、各種手続き情報など、あらかじめ設定されたコンテキストを基に、従業員の質問に対し迅速に回答が可能なシステムを構築できます。こうしたチャットボットは、業務効率化だけでなく、従業員のストレス軽減にも寄与し、結果として全体の生産性向上に貢献します。

実際の実装例では、ConversationBufferMemoryを利用して会話の文脈を保持し、連続性のある対話を実現しています。また、生成AIの基本とも連携し、最新のAI技術を取り入れた高度な運用が可能です。

from langchain import LLMChain, PromptTemplate

from langchain.llms import OpenAI

from langchain.memory import ConversationBufferMemory

# LLMの初期化

llm = OpenAI(temperature=0.7)

# プロンプトテンプレートの定義

template = """

You are an AI assistant for a company. Use the following pieces of context to answer the human's question.

If you don't know the answer, just say that you don't know, don't try to make up an answer.

Context: {context}

Human: {human_input}

AI: """

prompt = PromptTemplate(

input_variables=["context", "human_input"],

template=template

)

# メモリの初期化

memory = ConversationBufferMemory(input_key="human_input")

# チェーンの作成

chain = LLMChain(

llm=llm,

prompt=prompt,

verbose=True,

memory=memory

)

# コンテキスト情報(会社の規則やFAQなど)

company_context = """

Our company, TechInnovate, is a software development firm specializing in AI and machine learning solutions.

We have a flexible work policy allowing 2 days of remote work per week.

The standard working hours are from 9 AM to 6 PM with a 1-hour lunch break.

We offer 20 days of paid vacation per year, which increases by 1 day for every year of service, up to a maximum of 25 days.

"""

# チャットボットの使用例

while True:

user_input = input("You: ")

if user_input.lower() == 'exit':

break

response = chain.predict(human_input=user_input, context=company_context)

print("AI:", response)このチャットボットは、社内のルールやFAQなどのコンテキストを的確に把握し、従業員の問い合わせに対して即時かつ正確な回答を提供します。こうしたシステムは、人事部門の作業負荷を軽減し、従業員が必要な情報に迅速にアクセスできる環境を整え、業務の効率化に大いに貢献します。

URLからのサイト要約生成

大量のウェブコンテンツが存在する現代において、特定のURLから自動的にウェブページの内容を要約するツールは非常に有用です。LangChainを使用すれば、WebBaseLoaderを用いて指定されたURLのページを読み込み、load_summarize_chainによって自動的に要約を生成することができます。このプロセスは、研究者やアナリストが短時間で膨大な情報を把握するための強力なツールとして機能し、情報のダイジェスト作成に大いに役立ちます。

from langchain.chains.summarize import load_summarize_chain

from langchain.document_loaders import WebBaseLoader

from langchain.llms import OpenAI

# LLMの初期化

llm = OpenAI(temperature=0.7)

# URLからコンテンツを読み込むローダーの作成

loader = WebBaseLoader("https://example.com")

# ドキュメントの読み込み

docs = loader.load()

# 要約チェーンの作成

chain = load_summarize_chain(llm, chain_type="map_reduce")

# 要約の実行

summary = chain.run(docs)

print(summary)上記の実装例では、WebBaseLoaderで指定したURLからコンテンツを取得し、load_summarize_chainを使って効率的な要約処理を実現しています。長文のウェブページも、「map_reduce」方式を採用することで、要点がしっかりと抽出され、理解しやすい形にまとめられます。こうしたツールは、情報過多の時代において、迅速なデータ分析やレポート作成に大いに活用できるため、研究論文やビジネス文書のレビューにも応用されています。

また、Notion AIのような文書管理ツールと連携することで、ドキュメント全体の管理効率が向上し、業務全体のデジタルトランスフォーメーションを促進することが期待されます。

PDFファイルの検索と抽出

大量のPDFドキュメントを対象に、特定の情報を高速に検索・抽出するシステムは、法律事務所や研究機関において非常に有効です。LangChainを利用すれば、PyPDFLoaderによるPDFファイルの読み込みから、Chromaベクトルストアによるデータのインデックス作成、さらにRetrievalQAチェーンによる質問応答機能を実現でき、効率的な情報検索が可能となります。こうしたシステムは、文書管理の自動化と、検索品質の向上を図る上で大きなメリットを提供します。

ユーザーは膨大な文書データの中から必要な情報を即座に抽出できるため、非常に効率的な業務遂行が期待できます。

from langchain.document_loaders import PyPDFLoader

from langchain.vectorstores import Chroma

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.llms import OpenAI

from langchain.chains import RetrievalQA

# PDFファイルの読み込み

loader = PyPDFLoader("path/to/your/document.pdf")

pages = loader.load_and_split()

# ベクトルストアの作成

embeddings = OpenAIEmbeddings()

vectorstore = Chroma.from_documents(pages, embeddings)

# LLMの初期化

llm = OpenAI(temperature=0.7)

# 検索と質問応答のチェーンの作成

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=vectorstore.as_retriever()

)

# 質問と回答

query = "What are the main topics discussed in this document?"

response = qa_chain.run(query)

print(response)この実装例では、PDFファイルから情報を抽出し、Chromaベクトルストアを活用して効率的な情報検索と質問応答を実現しています。業務上の文書検索や法的文書のレビュー、さらには研究データの迅速な分析まで、幅広い用途に応用可能です。こうしたシステムを導入することで、煩雑な作業も自動化され、時間と労力の大幅な削減が期待できます。

これらの具体的なアプリケーション例は、LangChainが持つ多機能性と柔軟性を存分に活かすものです。次のセクションでは、LangChainを使う際の注意点について、ライセンス、トラブル対策、アップデート時の留意事項を詳しく解説します。

LangChainを使う上での注意点

LangChainは非常に高機能なツールですが、その効果を享受するためには、いくつかの重要な注意事項を把握しておく必要があります。ここでは、ライセンスや利用規約、トラブルシューティング、またアップデート時のポイントなど、実際に運用する上で知っておくべき事項を詳しく解説します。これらは、システムの安定運用とトラブル回避、さらには法的リスクの低減に直結するため、開発者や運用担当者は必ず確認しておくことが重要です。

ライセンスに関する注意事項

LangChainを使用する際は、オープンソースライセンスおよび利用する各種LLMのライセンスに関する注意が必要です。LangChain自体はMITライセンスに基づき公開されていますが、商用利用する際には各種ライセンス条項の遵守が求められます。また、OpenAI GPTやGoogle PaLMなど、利用するLLMのライセンス契約や追加費用が発生する可能性があるため、必ず事前に確認してください。

これらのライセンス条件の遵守は、法的リスクを回避し、持続可能なシステム運用を確保するための基本となります。内部での運用ルールや法務部門との連携も、適切に行うよう心がけましょう。

トラブル時の対処法とサポート体制

LangChainを利用している際には、公式ドキュメント、GitHub Issues、コミュニティフォーラムなどを活用することがトラブルシュートにおいて極めて有用です。具体的には、発生した問題の詳細なエラーメッセージや再現手順を記録し、まずは公式ドキュメントや既存のIssueを確認して、対策方法を探ることが必要です。また、大規模なプロジェクトでは有償サポートの利用を検討することで、迅速な問題解決が期待できます。

こうした体制を整えることで、運用時の不測の事態にも冷静かつ迅速に対応できる環境を構築できます。

更新やアップデート時のポイント

LangChainは日々アップデートが行われ、最新機能や改善点が積極的に導入されています。更新時には、GitHub Releasesや変更ログを必ず確認し、破壊的変更や依存ライブラリのバージョンアップに注意する必要があります。また、新バージョンの導入前には、テスト環境で動作確認を十分に行い、本番環境への影響を最小限に抑えることが求められます。

こうしたアップデートのプロセスを慎重に管理することで、システムの安定性とセキュリティを維持し、最新の技術トレンドを取り込むことが可能となります。特に、依存関係の管理は更新作業の中でも重要なポイントであり、継続的なテストと文書の更新を怠らないようにしましょう。

また、AI副業で稼ぐ方法などの最新の分野動向を参照しながら、技術の進化に合わせた柔軟な対応を心がけると、競争力のあるサービス提供にもつながります。

LangChainを効果的に活用するためには、これらの注意事項をしっかり把握し、継続的な学習と運用改善に努めることが不可欠です。技術革新のペースが速い分野であるため、最新の情報やベストプラクティスを積極的に取り入れて、システムの品質と信頼性を常に向上させるよう努めましょう。

まとめ

LangChainは、LLMを活用した高度なAIアプリケーション開発を実現するための極めて強力なフレームワークです。そのモジュール性、柔軟性、拡張性により、シンプルなチャットボットから複雑な意思決定システムまで、幅広い用途に対応可能です。本記事で解説した基本概念から具体的な実装、さらには運用上の注意点に至るまで、豊富な情報を提供しました。

生成AIの基本技術や、NVIDIA AI技術など、関連分野の最新動向も含め、今後ますます重要となるこの技術をぜひ活用してください。持続的な学習と技術の進化に注視しながら、LangChainを用いた革新的なアプリケーション開発に挑戦していただければ幸いです。