AINOW(エーアイナウ)編集部です。この記事では、AIと機械学習の最先端を担うオープンソースプラットフォーム「Hugging Face」について、その基本概念から活用事例、技術的背景、安全性や商用利用のポイントまでを幅広く解説しています。読者は、Hugging Faceの魅力や具体的な利用方法、さらに内部リンクを通じた関連情報(例:生成AIの基本、ChatGPTの活用、Stable Diffusion など)にも触れることで、実践で役立つ情報と最新の技術動向を得られます。

これからHugging Faceの多様な機能や実際の利用シーンについて、詳しくご紹介していきます。

サマリー: 本記事は、Hugging Faceの概要、提供されるモデルやライブラリ、活用方法、安全性対策、そして商用利用・料金プランに至るまで幅広い視点から解説しています。さらに、原神に関連する生成AIモデルやLoRA(Low-Rank Adaptation)の利用方法といった実用的な情報も盛り込まれており、開発者や研究者だけでなく、AI技術に興味を持つ全ての読者にとって貴重な知見を提供します。

Hugging Faceとは

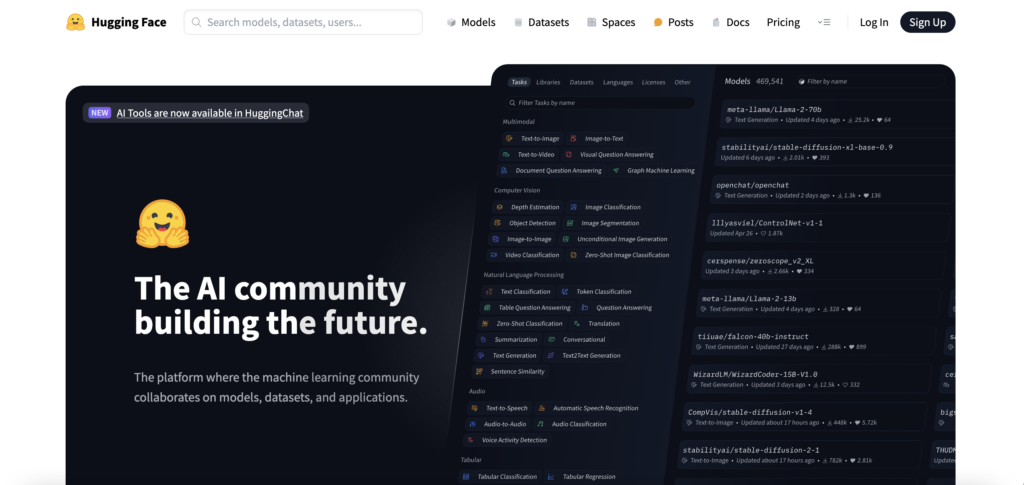

Hugging Faceは、自然言語処理(NLP)や画像生成、さらには幅広い機械学習タスクに対応するために開発されたオープンソースプラットフォームです。企業や個人がAIモデルの共有、カスタマイズ、デプロイを手軽に行える環境を提供しており、近年急速に発展する生成AIの分野において注目を集めています。各種モデルの利用はもちろん、データセットやツール群を通じた開発支援も特徴で、企業の生成AI活用事例など現場での利用シーンが非常に豊富です。

- 事前学習済みモデルの提供

- Hugging Faceでは、テキスト分類、質問応答、テキスト生成などの自然言語処理タスクに最適化された高精度な事前学習済みモデルが数多く提供され、迅速なプロトタイピングが可能になります。

- データセットの提供

- 研究や実務に必要な多様なデータセットが、感情分析や機械翻訳など、さまざまなタスク向けに提供され、迅速な実験環境の整備をサポートします。

- モデルのファインチューニング

- 既に学習済みのモデルを、自身の特定用途向けにカスタマイズすることができ、転移学習などを用いた応用が容易に行える点が大きな魅力です。

- APIの提供

- 外部アプリケーションやサービスとの連携も可能なAPIが提供されており、クラウド環境(たとえばAzure生成AI、Microsoft生成AIなど)との統合によるスケーラブルなサービス提供が実現可能です。

Hugging Faceは、AIと機械学習の研究・開発を大きく前進させるためのハブとして機能します。大規模なオープンソースコミュニティに支えられており、利用者同士の知見共有や協業が進んでいる点も大きな強みです。特に、最新のRAG技術などを含む多岐にわたる技術領域との融合事例も増えており、今後ますます注目されるプラットフォームとなっています。

- Hugging Face Hub: ユーザーは、自作のAIモデルやデータセットをアップロードし、他の研究者や開発者と共有することが可能です。約90万近いモデルが登録され、多彩な用途に対応しています。

- Transformersライブラリ: 自然言語処理や画像認識に特化した多数の事前学習済みモデルが含まれており、最新の技術をベースに、簡単に転移学習や微調整が行える仕組みが整っています。さらに、このライブラリは生成AIの最新トレンドを取り入れており、生成AIの基本を学び始めたい方にも分かりやすい構造となっています。

- Datasetsライブラリ: 多様な機械学習用データセットへのアクセスを容易にし、データ前処理の負担を大幅に軽減します。研究者は迅速に実験環境を構築でき、その結果を効率的に評価できます。

- Tokenizersライブラリ: 大規模なテキストデータを迅速かつ効率的に処理するためのツールであり、解析の精度や速度の向上に寄与しています。

- Spaces: 開発者や研究者が自作のAIモデルのデモを作成し、ウェブ上で共有できるインタラクティブな環境を提供しています。これにより、プロジェクトの成果を直感的にアピールでき、フィードバックを得る機会が拡がります。

Hugging Faceを利用するメリット

Hugging Faceを活用することにより、さまざまなメリットがあります。多くの開発者や企業がこのプラットフォームを利用する理由を、以下の項目に沿って詳しく解説します。なお、NVIDIA AI技術との連携例など、他社サービスとの比較検討も可能なため、幅広い視点から活用が進んでいます。

- 最先端のAIモデルを手軽に利用できる

- 本プラットフォームにより、高性能な事前学習済みモデルをワンクリックで試用でき、実務で役立つプロトタイピングが可能となります。開発の初期段階から効率的にプロジェクトを進めることができる点が非常に大きなメリットです。

- AWSなどのクラウドと連携が可能

- 例えば、AWSのSageMakerなどと組み合わせることで、モデルの大規模な学習やデプロイメントが円滑に進み、運用コストを最適化できます。そのため、企業のシステムに迅速にAI技術を導入する際の重要な橋渡しとなっています。

- オープンソースコミュニティによる知見の共有

- グローバルなコミュニティが参加するオープンソースプロジェクトだからこそ、利用者間で最新の技術情報やノウハウが共有され、自然と新たなイノベーションが生まれる環境が整っています。

- 無料で利用可能なデータセットが豊富

- 多くのデータセットは基本無料で利用できるため、研究や試作段階での初期コストを大幅に削減し、学習プロセスを迅速化する助けとなります。

Hugging Faceは、2016年にClement Delangueらによってニューヨークで設立され、現在ではグローバルに展開する企業として評価されています。初期のオープンソース精神を貫き、最新技術と共同作業の場を提供することで、今後のAI技術発展に大きく寄与すると期待されています。

参考リンク

Hugging Faceのモデル一覧

利用可能なモデルの一覧と特徴

概要

Hugging Faceは、広範な自然言語処理(NLP)と生成AIモデルの宝庫として知られています。提供されるモデルは、テキスト理解、生成、翻訳、画像生成など多彩であり、ユーザーの多様なニーズに対応するよう設計されています。これにより、エンタープライズから個人プロジェクトまで、幅広い分野で利用されています。

主なモデル

- BERT: 自然言語の文脈理解に特化したモデルで、質問応答やテキスト分類、さらには意図解析など幅広いNLPタスクに採用されています。高い精度と柔軟性が特徴で、他のモデルとの比較検討にもしばしば利用されます。

- GPT-3: 高度なテキスト生成モデルとして、対話型エージェントや自動文章生成、コンテンツクリエーションに広範に活用されており、特に大規模なデータを必要とするシーンで高いパフォーマンスを発揮します。

- T5: テキスト変換に特化したモデルで、翻訳、要約、パラフレーズ生成など、入力テキストを別の形式に変換するタスクに最適です。柔軟なアーキテクチャにより、さまざまなタスクへの応用が容易です。

- RoBERTa: BERTの改良版として、生のテキストから高い情報抽出能力を実現し、より精度の高いNLPタスクに対応します。また、学習の過程で様々なデータに対する汎化性能が向上している点が評価されています。

- Stable Diffusion: テキストから画像を生成する革新的なモデルで、クリエイティブなアートワークやビジュアルコンテンツの作成に利用され、近年の画像生成技術の進展を象徴する存在です。

参考リンク

Hugging Faceの使い方

基本的な利用方法

概要

Hugging Faceを利用するための基本的なアプローチは、Python用ライブラリ「transformers」を活用することです。このライブラリを通じて、事前学習済みモデルのロード、ファインチューニング、各種推論タスクの実行がシンプルに行えます。さらに、使い方についての詳細は、ChatGPTの活用事例とも連動しており、わかりやすい実例が豊富に存在します。

利用手順

- ライブラリのインストール:

- Python環境にて、必要なパッケージをpipでインストールします。これにより「transformers」ライブラリが利用可能となり、環境構築が完了します。

pip install transformers- モデルのロード:

- ライブラリをインポートして、使用するモデル名を指定し、適切なパイプラインを初期化します。たとえば、テキスト生成用にGPT-3を使った例が挙げられます。

from transformers import pipeline

model = pipeline("text-generation", model="gpt-3")- テキスト生成:

- モデルに入力テキストを渡し、生成された結果を取得します。これにより、創造的な文章や対話のシミュレーションを簡単に行えます。

result = model("Once upon a time,")

print(result)参考リンク

Hugging Faceの画像生成

画像生成モデルの利用方法

概要

Hugging Faceは、テキストから鮮明かつクリエイティブな画像を生成するモデルも提供しています。特に、Stable Diffusionと呼ばれるモデルは、美しい風景やアートワークの生成において大きな注目を集めています。こうした技術は、マーケティング用のビジュアル制作やコンテンツクリエーション、デザインのインスピレーションに最適です。

利用手順

- ライブラリのインストール:

- 画像生成に特化したdiffusersライブラリをpipでインストールします。これにより、Stable Diffusionの利用が可能となります。

pip install diffusers- モデルのロードと画像生成:

- ライブラリからStable Diffusionパイプラインをインポートし、事前学習済みモデルをロードします。その後、テキスト入力をもとに画像を生成し、保存します。具体的なコード例を下記に示します。

from diffusers import StableDiffusionPipeline

model = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4")

image = model("A beautiful landscape with mountains and rivers")

image.save("output.png")参考リンク

Hugging Faceの安全性

利用時の安全性とプライバシー

概要

Hugging Faceは、利用者のデータ保護およびプライバシーの維持に努めています。プラットフォームは、データの転送や保存において暗号化技術を採用し、セキュリティ対策を定期的にアップデートしています。また、明確なプライバシーポリシーに基づいて、ユーザー情報を管理しているため、安心して利用することができます。

主なポイント

- データ暗号化: データ送信時およびストレージ時に高度な暗号化技術を使用し、漏洩リスクを最小限に抑えています。

- プライバシーポリシー: ユーザーの個人情報を保護するための厳格なポリシーが策定されており、透明性の高い運用が行われています。

- セキュリティアップデート: 定期的な脆弱性評価とセキュリティパッチの提供により、最新の攻撃手法にも対応しています。

参考リンク

Hugging Faceのダウンロード方法

モデルのダウンロードとセットアップ

概要

Hugging Faceのモデルは、シンプルな手順でダウンロードし、ローカル環境やクラウド上にセットアップできます。これにより、開発や実験に必要なすぐに使用可能な状態が整えられます。ライブラリの利用方法とモデルの保存手順を通じて、プロジェクトの迅速な立ち上げが可能です。

利用手順

- ライブラリのインストール:

- まず、必要なPythonライブラリ(例:transformers)をpipでインストールし、環境準備を行います。

pip install transformers- モデルのダウンロード:

- transformersライブラリを利用して、AutoModelForCausalLMおよびAutoTokenizerクラスを用いたモデルの取得と初期化を行います。

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "gpt-2"

model = AutoModelForCausalLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)- モデルの保存:

- ダウンロードしたモデルとトークナイザーをローカルディスクに保存することで、再利用を容易にし、後のファインチューニングやデプロイメントに活用できます。

model.save_pretrained("./my_model")

tokenizer.save_pretrained("./my_model")参考リンク

Hugging Faceの商用利用

Hugging Faceの提供するモデルやデータセットは、各種ライセンスの下で配布されており、商用利用についても明確な基準が設けられています。企業での利用を考慮する場合、ライセンス内容の確認と合わせて、法的なリスクの低減策を講じることが重要です。実際に、NVIDIA AI技術との連携事例なども参考にしながら、各モデルの利用条件を慎重に評価してください。

商用利用の可否

- 商用利用の可否: 多くのモデルはオープンソースライセンスに基づいており、基本的には商用利用が認められています。しかし、ライセンスごとに細かい条件や制限が異なるため、各モデルの詳細なライセンス情報を確認することが推奨されます。

ライセンスの種類

- ライセンスの種類: 一般的に利用されるライセンスには、MITライセンス、Apache 2.0、Creative Commons(CC)などがあります。これらは商用利用を許可する場合が多いですが、著作権表示の保持や改変の制限といった条件が設定されることもあるため、使用前に確認してください。

具体的な制限

- 具体的な制限: 一部のモデルでは、元のライセンスに商用利用禁止の条項が付加されているケースも見受けられます。具体例としては、「Cool Japan Diffusion」モデルが挙げられ、商用利用に当たっては法的助言のもと慎重に対応する必要があります。

ファインチューニングとデータセット

- ファインチューニングとデータセット: 商用向けにモデルを最適化する場合、利用するデータセットにも商用利用が許可されているかを確認する必要があります。特に、データセットの転用やファインチューニングに伴い適用されるライセンスに従うことが不可欠です。

注意点

- 注意点: 商用利用を検討する際は、必ず各モデルやデータセットのライセンス条件を熟読し、追加の制約がある場合には法務部門との協議を行ってください。特に、元データの著作権表記や改変禁止の規定がある場合は、それに準じた運用が求められます。

上記のポイントを踏まえ、Hugging Faceのモデルを商用利用する際には、各ライセンス条項に細心の注意を払いながら利用することが重要です。これにより、企業活動におけるリスクを抑えつつ、最新の技術を効果的に導入することが可能となります。

Hugging Faceの料金プランについて

Hugging Faceは、AIモデルやデータセットの共有、機械学習ツールの運用を支えるプラットフォームとして、多様な料金プランを用意しています。2023年から2024年にかけて提供されるプランは、個人開発者から大企業まで幅広いニーズに応える設計となっており、開発現場ではその柔軟性とコストパフォーマンスが非常に高く評価されています。

- Hugging Face Hub: 基本的な無料プランでは、モデルやデータセットのホスティングが無制限に利用でき、プライベートリポジトリも含めた柔軟な環境が整えられています。常に最新の機械学習ツールとオープンソースリソースにアクセス可能です。

- PROプラン: 月額9ドルで提供され、ZeroGPUやDev Mode for Spacesなど、開発者向けの先進的な機能が利用可能になります。高いリクエスト上限や早期アクセス機能により、短期間での成果創出が期待できます。

- Enterprise Hubプラン: 月額20ドル/ユーザーから導入可能で、シングルサインオン(SSO)、データ保存場所の選択、詳細な操作ログ管理、優先サポートなど、企業向けのエンタープライズ機能が充実しています。

- Spaces Hardwareプラン: 高度なアプリケーションの運用に最適化されたハードウェア環境を提供。利用料金は時間単位で計算され、柔軟なスケーリングが可能です。

- Inference Endpointsプラン: モデルのデプロイと自動スケーリングが可能なインフラを提供し、時間あたり0.032ドルから利用可能。定量的なコスト管理がしやすく、実運用環境での活用に適しています。

Hugging Faceと原神

原神に関連する生成AIモデルの利用

概要

Hugging Faceでは、原神(Genshin Impact)関連の生成AIモデルも提供され、ゲーム内コンテンツやキャラクターのテキスト生成など、独自コンテンツの作成に利用できるようになっています。このような技術は、ファンコミュニティの活性化や、ゲームマーケティング用の素材生成に大きな可能性を秘めています。

利用手順

- モデルの検索: Hugging Faceのモデルページにて、「Genshin Impact」や「原神」といったキーワードで検索し、対象のモデルを絞り込みます。

- モデルのロード:

- 該当するモデルとトークナイザーをインポートし、使用する準備を行います。特に、テキスト生成タスクに最適化されたモデルが利用されます。

from transformers import AutoModelForSeq2SeqLM, AutoTokenizer

model_name = "genshin-model"

model = AutoModelForSeq2SeqLM.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)- 生成の実行:

- モデルに、キャラクターの特徴説明などの入力テキストを与え、結果のテキストを生成します。具体的なシナリオとして、Dilucのキャラクター解説などが挙げられます。

input_text = "Describe the character of Diluc from Genshin Impact."

inputs = tokenizer.encode(input_text, return_tensors="pt")

outputs = model.generate(inputs)

print(tokenizer.decode(outputs[0]))参考リンク

Hugging FaceでのLoRAの探し方

LoRA(Low-Rank Adaptation)のモデル検索方法

概要

LoRA(Low-Rank Adaptation)は、既存の大規模なモデルに対して効率的にタスク特化型の調整を行うための技術です。Hugging Faceでは、簡単な検索でLoRA対応モデルを見つけることができます。この手法は、少ない追加パラメータでモデルのパフォーマンスを向上させるため、計算資源の節約にも大いに貢献します。

利用手順

- Hugging Faceモデルページにアクセス: Hugging Faceモデルページへアクセスし、豊富なモデルリストから探します。

- 検索フィルターの設定: 検索バーに「LoRA」と入力し、関連するモデルを迅速に特定します。

- モデルの詳細確認: 検索結果から目的に合致するモデルを選び、その詳細な仕様やライセンス情報を確認します。

- モデルの利用:

- 選定したモデルをインポートし、通常のモデル利用プロセス(ロードや推論)に組み込みます。

from transformers import AutoModel, AutoTokenizer

model_name = "lora-model"

model = AutoModel.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)